Linux内核深入理解全集

Linux 内核深入理解 - 绪论

任何计算机系统都包含一个名为操作系统的基本程序集合!在这个集合里最重要的程序被称为内核。当操作系统启动的时候内核会被装进RAM当中。

操作系统说来说去就是两个主要目标:他充当底层的物理部件好用的抽象,给予上层服务一个好的平台

- 与硬件部分进行交互,为包含在硬件平台上的所有底层可编程部件提供服务!

- 为运行在计算机系统上层的应用程序即所谓的用户程序提供一个执行环境!

为了保障安全。我们的操作系统引入了一组概念,也就是用户模式和特权模式。我们会在之后的博客中有所涉及:简单的讲:一些涉及到底层硬件访问的操作需要在特权模式下进行,反之则会在用户模式下进行!程序的运行有时会在两者之间进行频繁的切换,从而更好地完成程序所提供的服务。

多用户系统

多用户系统就是一台能够并发的执行和独立的执行分别属于两个或者多个用户的若干应用程序的计算机。

并发意味着几个应用程序同时处于活动状态执行自己应用进程所需要执行的任务,而并不需要考虑其它应用程序在做什么!

多用户操作系统必须包含以下几个特点

- 核实用户身份的认证机制

- 防止有错误的用户程序妨碍其它应用程序在系统中运行的保护机制

- 防止有恶意的用户程序干涉或者窥视其他用户的活动的保护机制

- 限制分配给每个用户的资源数的记账机制

于是我们会把用户进行分为用户组在多用户系统中每个用户在机器上都会有自己的私用空间!典型的它需要一些磁盘空间来存储文件!以及接受私人邮件信息等!这一些都需要分层的特权来实现一定的保护机制!

所有的用户都用一个唯一的数字来进行标识,也就是用户标识符!通常一个计算机系统只能够由有限个人来使用。当其中的某个用户开始一个工作session的时候,操作系统会要求输入一个登录口令。如果用户输入无效则会拒绝登录,从而保障用户的隐私。

进程

所有的操作系统都有一个基本的抽象:也就是进程!

进程可以定义为一个程序执行时的一个实例或者一个运行程序所使用的上下文。在传统的操作系统中:一个进程在地址空间中执行一个独立的指令序列,地址空间是允许引用的内存地址集合。

在多用户系统中必须实施一种执行环境:在这样的环境里,几个进程可以并发的活动,并能竞争系统资源。允许进程并发活动的系统叫多道程序系统或多处理系统。

作为一个单处理器系统上,只有一个进程能够占用CPU。这也就意味着实际上只有一条执行流,那么他们是如何实现一种感官上的并发呢?

这需要操作系统的进程是抢占式的!也就是说操作系统需要记录每个进程所占有的CPU时间,并且周期性地激活调度程序。以保证感官上的并发!Unix操作系统是一个具有抢占式进程的多处理操作系统。换而言之,Unix操作系统是一个抢占式的多道处理操作系统!

内核体系架构

大部分Unix内核是单块结构的!也就是说它们属于宏内核操作系统!每一个内核层都被集成到整个内核程序中,并且代表当前进程是在内核态下运行!相反微内核操作系统只需要内核有一个很小的函数:即通常包括几个同步原语,一个简单的调度程序,和IPC通信机制。运行在微内核上的几个系统进程实现宏内核操作系统实现的功能:如内存分配,设备驱动,系统调用处理等。

事实证明微内核操作系统的效率比较低,因为它需要花费大量的时间进行进程之间的通信。不过微内核操作系统比单核快内核有一定的理论优势,因为它强迫系统程序员采用模块化的方法来构建程序。所以Linux充分吸收了微内核操作系统的优点:提供了一个模块的机制!模块是这样的一个目标文件:它上面的代码可以在运行时链接到内核,或者从内核中解除链接。这种目标代码通常是由一组函数组成,从而来实现文件系统,驱动程序,或其他内核上层功能。

使用模块的主要优点有:

- 首先它保证了一种模块化的方法

- 其次它实现了一种平台无关性

- 接着它可以节省内存使用,当我们不再需要他的时候可以动态的进行解除,同样的在我们需要它的时候可以动态的进行加载

- 最后他无性能损失!

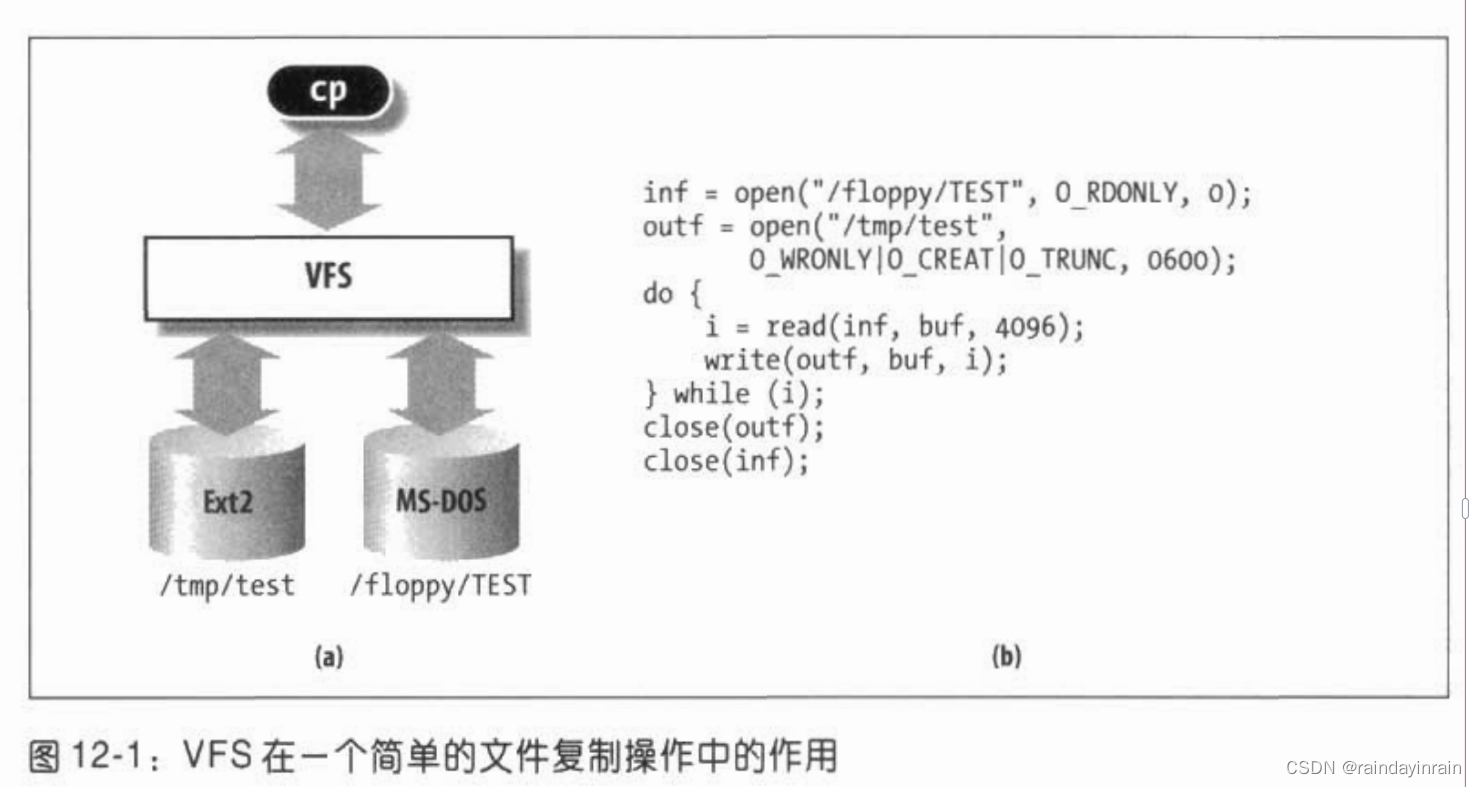

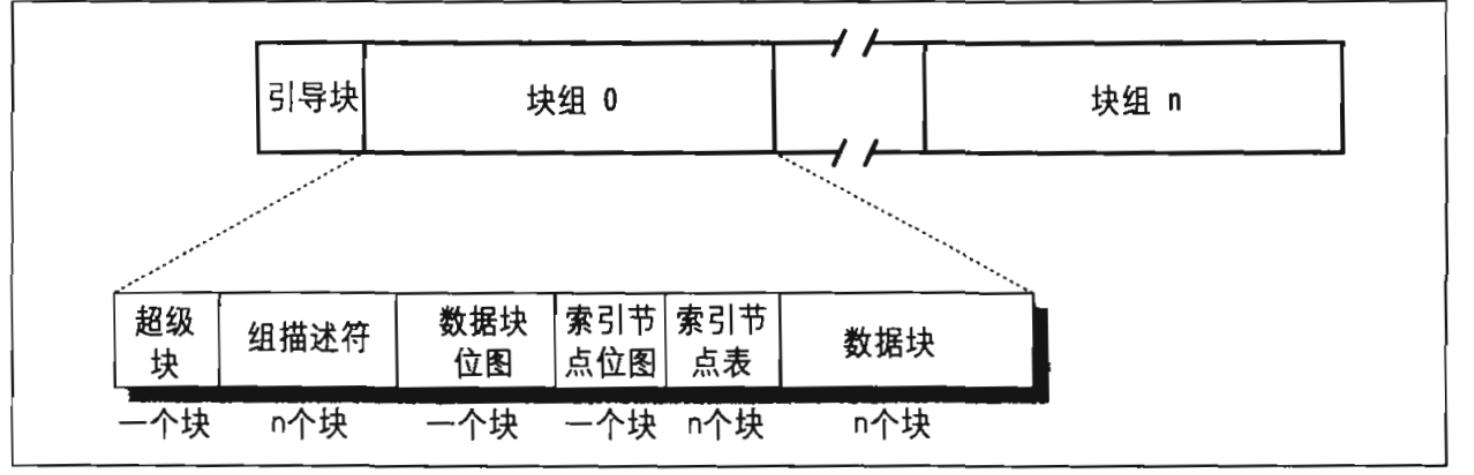

文件系统概述

Base

我们这样定义文件:

Unix文件是一个以字节序列组成的信息载体!

内核并不负责解释自己文件的内容!

文件或目录名由除/和空字符之外的任意ASCII字符序列组成!大多数文件系统对文件名的长度都会有所限制。(比如说我们的常见的Ext2是255,你不可以把文件名搞得太长!)

这个可以查看自己的ulimit值

与树的根相对应的目录被称为根目录,按照惯例它的名字是/

在同一目录中的文件名并不能相同,而在不同目录中的文件名则可以相同(因为可以通过连接不同的目录文件名从而唯一的标识这个文件)

Unix的每个进程都有一个工作目录(pwd,想你的shell怎么区分你当前在文件系统海洋的何处!)

当标识文件名时引用符号.和..:它们分别标识当前工作目录,和父目录。如果当前工作目录是根目录,那么这两个目录就是完全一致的!

硬链接和软链接

包含在文件目录的文件名就是一个文件的硬链接,或者简称链接。

在同一目录或不同的目录中同一个文件可以有好几个链接!因此对应几个文件名。

他有两方面的限制:首先他不允许用户给目录创建硬链接,因为这可能会把目录树变为环形图,从而就不可能通过名字来定位一个文件!

其次只有在同一文件系统中的文件才能创建链接!这带来比较大的限制!因为现在操作系统可能包含了多种文件系统!这些文件系统位于不同的磁盘和根目录或分区,用户也许无法知道它们的物理划分!

为了克服这些限制则引入了软链接,或者是符号链接。符号链接是短文件这些文件包含了另一个文件的任意路径名。路径名可以指向位于任意一个操作系统文件系统的任意文件或目录,甚至可以指向一个根本不存在的文件!

Unix文件类型

Unix文件类型可以是以下列的一种:

- 普通文件

- 目录

- 符号链接

- 面向块的设备文件

- 面向字符的设备文件

- 管道

- 命名管道

- 套接字

前三种文件类型是所有Unix文件系统的基本类型

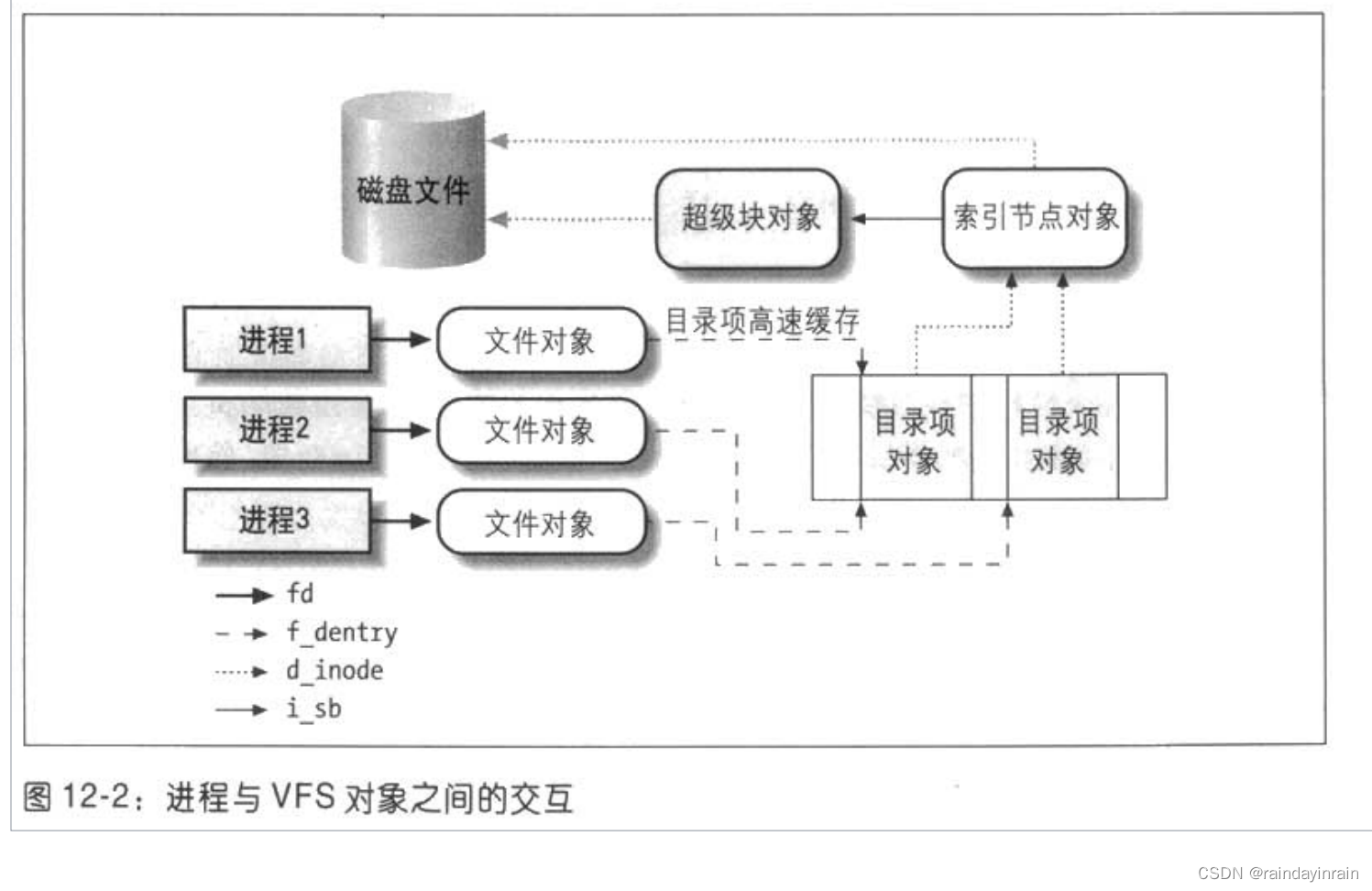

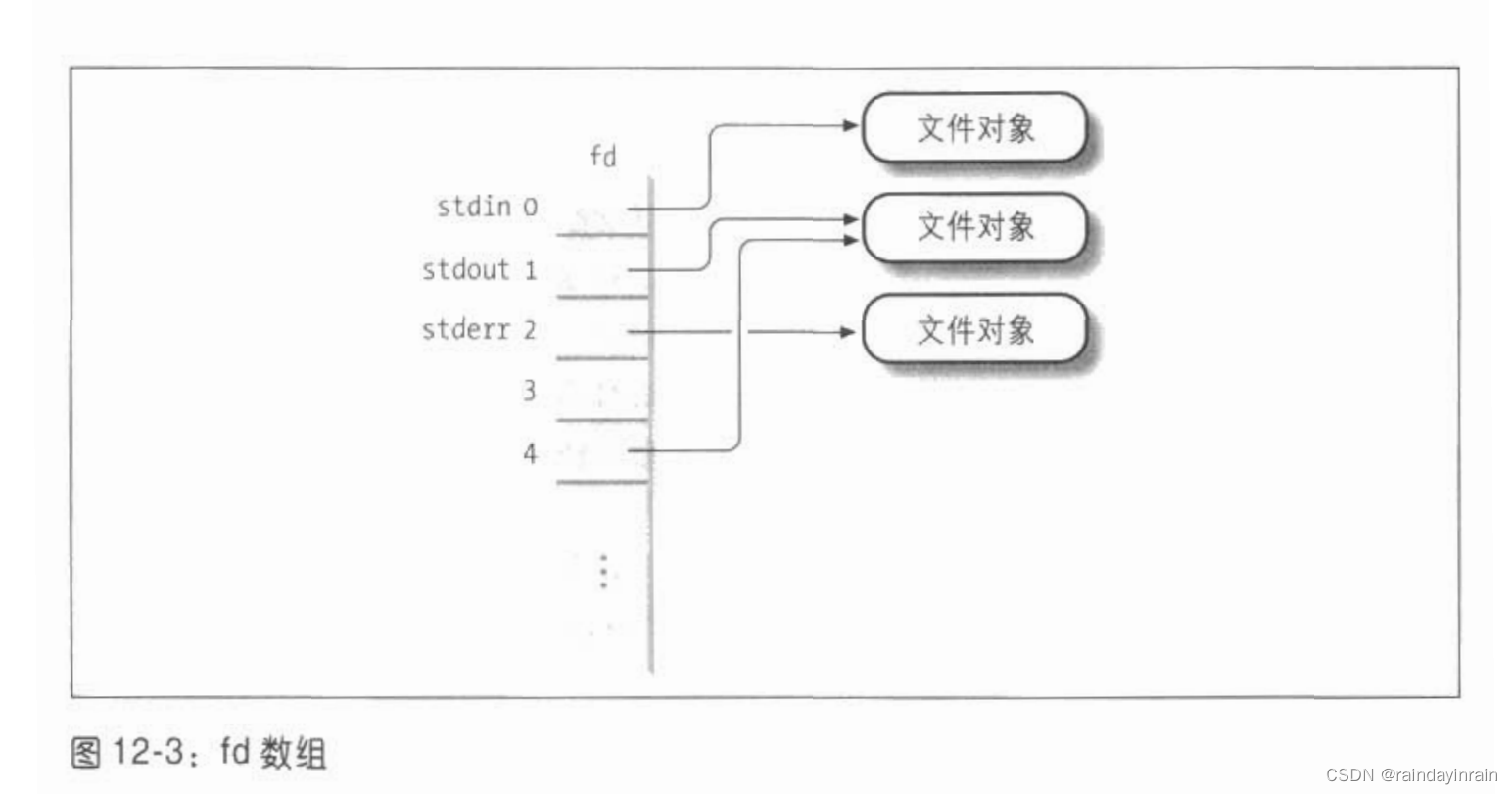

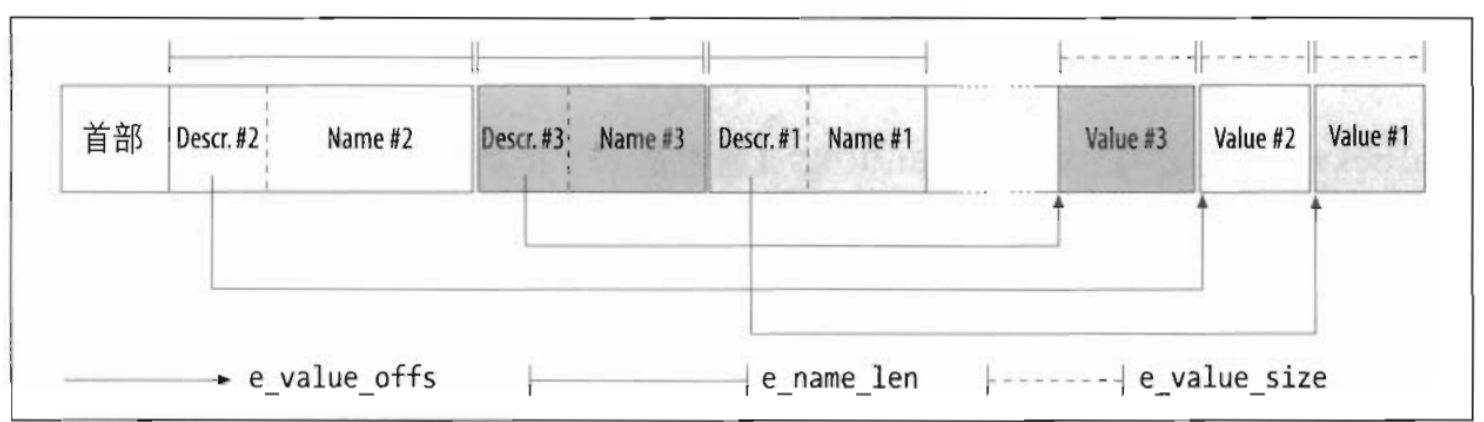

文件描述符与索引节点

Unix对文件的内容和描述文件的信息给出了清楚的区分!除了设备文件和特殊文件系统外,每个文件都由字符序列组成!文件内容不包含任何克控制信息!如文件长度或者文件结束符。

我们使用索引节点在内核中表示文件,从而代表一大块文件数据进行管理!

文件也有访问权限和文件模式:文件的潜在用户有三种

- 作为文件所有者的

- 用户同组用户但是不包括所有者

- 所有剩下的用户

文件有三种访问类型:读,写与执行!

文件操作的系统调用

有open, read, write, close等,这里我们暂时不加讨论!(可以参考Linux系统编程手册学习!)

Unix内核简述

我们下面重点来讨论Unix内核,首先我们要说的是进程/内核模式:

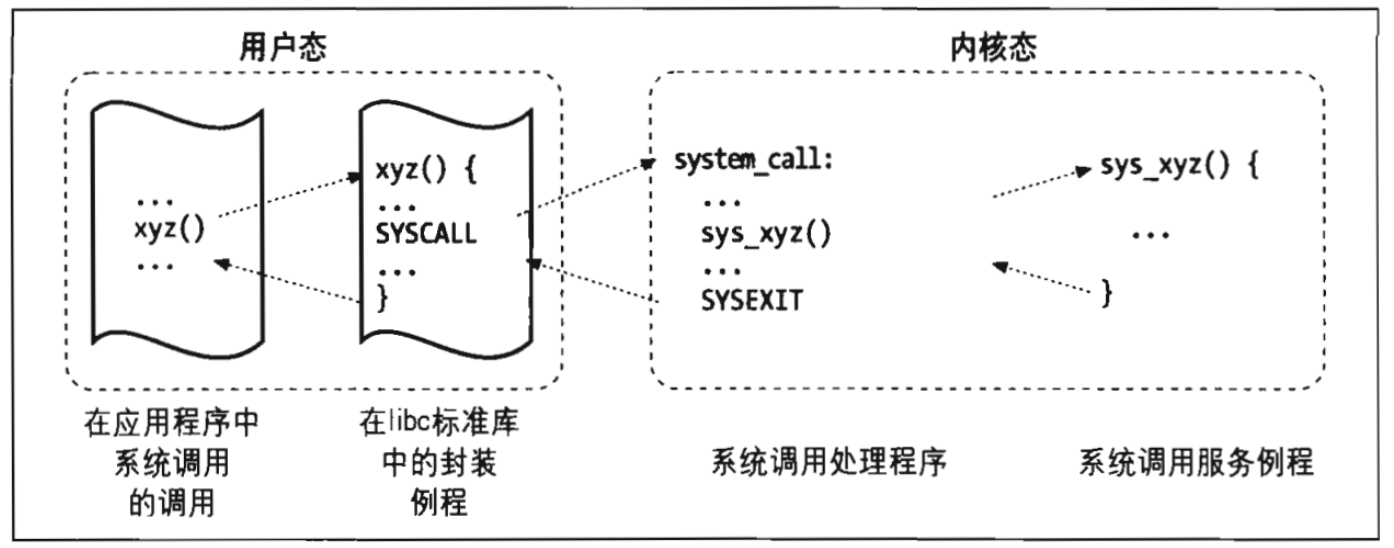

如前所述CPU既可以运行在用户态,也可以运行在内核态。当一个程序在用户态下执行的时候,它并不能直接访问内核的数据结构和程序,然而当应用程序在内核态下运行时则不再会有这些限制。当应用程序有所请求内核服务时,内核才会把这个进程流陷入内核态。当完成任务时把进程送回用户态。进程是动态的实体,在系统内通常只有有限的生存期。创建,撤销,同步现有进程的任务都要委托给内核中的一组例程来完成!

内核本身不是一个进程,而是进程的管理者。除用户进程之外:Unix系统还包括几个所谓的内核进程的特权进程。它们具有以下特点:

- 它们以内核态运行在内核地址空间

- 他们不与用户直接交互,因此不需要终端设备!

- 他们通常在系统启动时创建然后一直处于活跃状态直到系统关闭

进程的实现

为了让内核管理进程所有的进程都需要用一个进程描述符进行抽象。当内核暂停一个进程的时候,就会把几个相关处理器寄存器的内容保存在进程描述符里,包括:

- 程序计数器和栈指针寄存器

- 通用寄存器

- 浮点寄存器

- 包括CPU状态信息的处理器控制器

- 用来跟踪进程对RAM访问的内存管理寄存器

当内核决定恢复一个进程的时候,他用进程描述符中合适的字段来装载CPU寄存器。因为程序计数器中所存的值指向下一条将要执行的指令,所以进程恐怕停止的地方恢复执行!

可重入内核

所有的Unix内核都是可重入的!

这意味着若干个进程可以同时在内核态下执行,当然在单处理器系统上只有一个进程在真正的执行!但是有许多进程可能在等待CPU或者某一个IO操作完成时在内核台下被阻塞!

提供可重入的一种方式就是编写函数,以便这些函数只能更改局部变量,而不更改全局数据结构。这样的函数叫做可重入函数!

如果一个硬件中断发生,可重入内核可以挂起正在执行的进程,即使这个进程处于内核态

在最简单的情况下CPU从第一条指令到最后一条指令顺序的执行内核控制路径。也就是表示内核处理系统调用异常或中断所执行的指令序列

然而当下述事情发生之一,CPU交错执行内核控制路径:

- 运行在用户态下的进程调用了一个系统调用,而相应的内核控制路径。正是这个请求没有办法立即得到满足,然后内核控制路径调用调度程序选择一个新的进程。进行调度完成后,进程切换。发生第一个内核控制路径还没有完成,而CPU又重新执行其他的内核控制路径。在这种情况下,两条控制路径代表两个不同的进程。

- 在执行当执行一个内核控制路径时,CPU检测到了一个异常:比如说访问了一个不在RAM中的页,那么第一个控制路径将会被挂起,而CPU开始执行合适的过程。比如说在这个例子中我们则是给那进程分配一个新页,并从磁盘中读取它的内容。当这个过程结束后第一个控制路径可以恢复执行,在这种情况下两个控制路径代表同一个进程在执行

- 当CPU在运行一个启用了中断的内核控制路径时,一个硬件中断发生。一个控制路径还没执行完,CPU马上开始执行另一个内核控制路径来处理这个中断。当这个中断处理程序终止时,第一个内核控制路径恢复。在这个情况下两条内核控制路径运行是同一进程的可执行上下文。所花费的系统CPU时间都算给了这个进程。然而中断处理程序无需代表这个进程运行

- 在支持抢占式调度的内核中,CPU正在运行。但是被一个更加高级的进程加入就绪队列。中断发生,调度开始。第一个内核控制路径并没有执行完。CPU代表高优先级进程又开始了另一个内核控制路径,只有把内核编译成支持抢占式调度后才有可能会出现这种情况!(你放心,咱们就是这个hhh)

进程地址空间

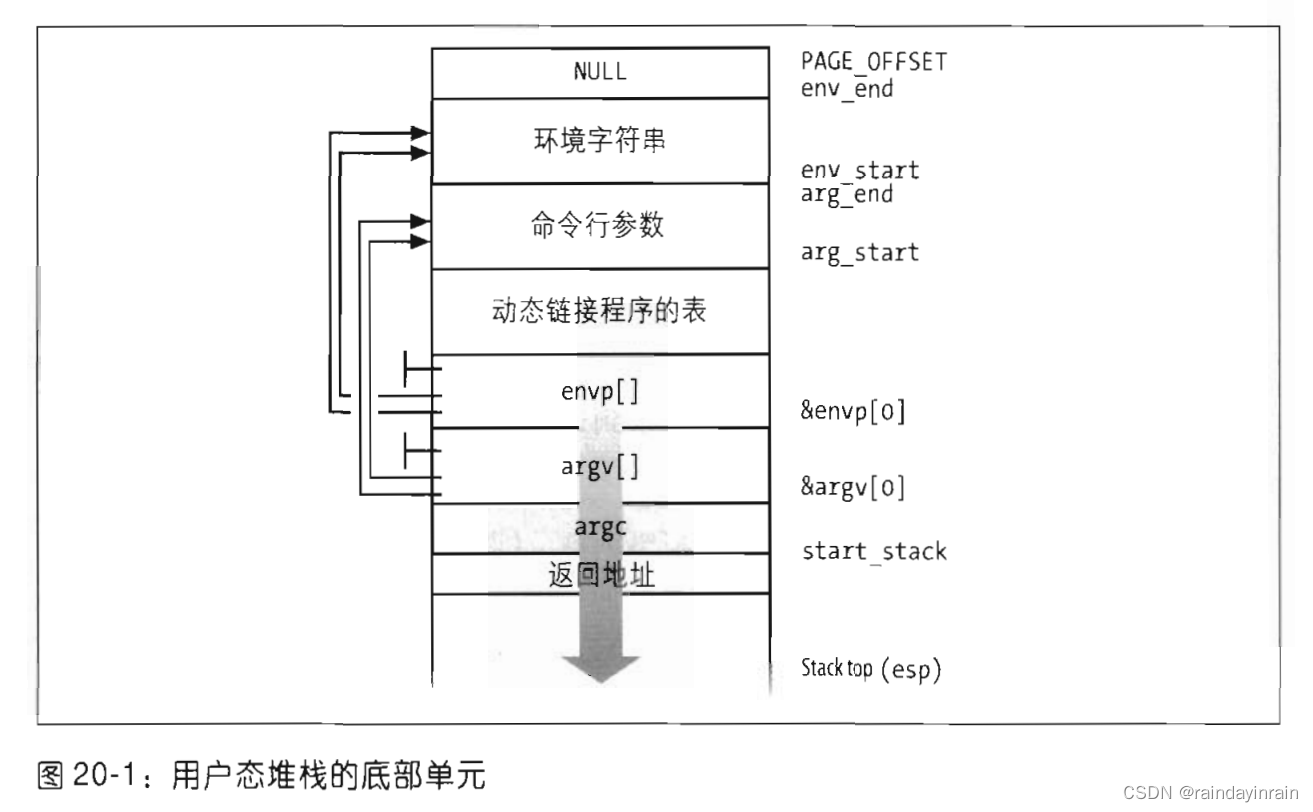

每个进程运行在它的私有地址空间!在用户态下运行的进程涉及到私有栈,数据区和代码区。

当在内核态运行时,进程访问内核的数据区,代码区。但是使用的是另外的私有栈。尽管看起来每个进程都在访问他们自己的私有栈,但是为了更好的进程间通信,有时进程之间也会共享部分地址空间!

Linux支持映射内存(mmap)系统调用,该系统调用将允许存放在块设备上的文件或信息映射到进程的部分地址空间。这为正常的读写传送数据方式提供了另一种选择

同步和临界区

实现可重入的内核需要利用同步机制,如果内核控制路径对某个内核数据结构进行操作被挂起时,那么其他内核控制路径就不应该对这个数据结构进行操作,否则会破坏一致性状态!

如何同步内核控制路径呢最彻底的办法就是使用非抢占式的内核(Weird huh?),其次就是禁止中断,再就是使用信号量自旋锁等内核机制来防止竞争条件!

在我们使用防止竞争条件的内核上锁机制时,需要避免死锁情况!在这里不予详细讨论!

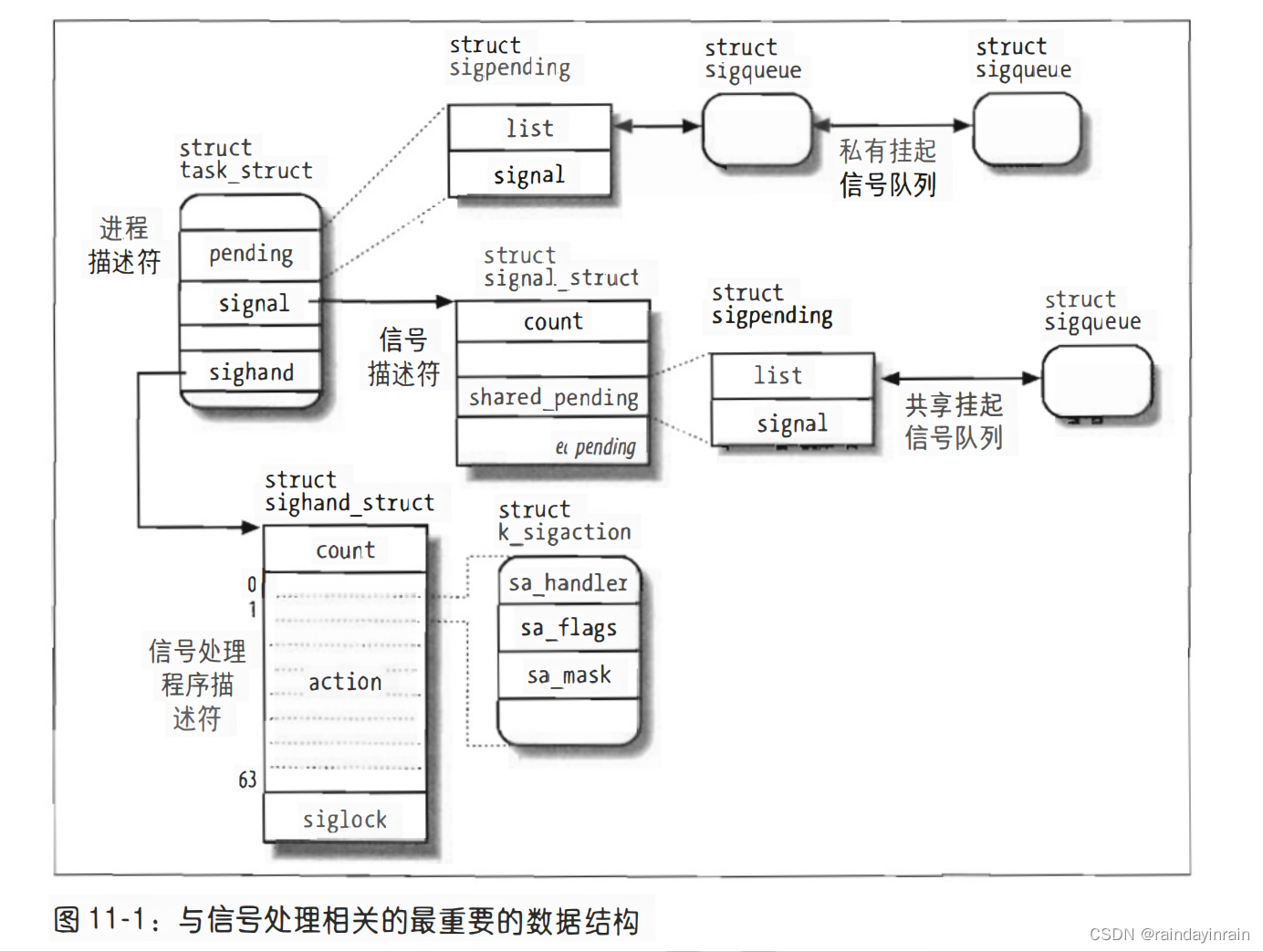

信号与进程之间的通信

Unix信号提供了一种把系统事件报告给进程的一种机制。

有两种系统事件:

- 异步通告

- 同步错误或异常

如果进程并没有指定如何处理信号时,内核会按照信号的编号进行默认操作。有可能有以下五种默认操作:

终止进程

将执行上下文和进程地址空间的内容写入一个文件,并且终止进程

忽略信号

挂起进程

如果进程曾被暂停,则恢复它

进程管理

Unix在进程和它正在执行的程序之间做出了清晰的划分!fork和_exit这两个系统调用分别用来创建一个进程和终止,与exec类系统调用则是装入一个全新的程序!以及还有僵死进程。如果父进程丢失了跟踪子进程的情况,那么这个子进程就认为僵尸进程。内核会检查子进程是否终止。引入僵死进程的特殊状态是为了表示终止的进程。很多内核也实现了waitpid系统调用,让父进程可以显示的等待一个特殊的子进程。对于那些已经成为僵尸进程的进程,他们将会被一个以init的特殊系统进程收养进行清除!

内存管理

虚拟内存

所有新进的Unix系统都提供了一种有用的抽象:叫做虚拟内存!

它作为一种逻辑层处于应用程序的内在请求与硬件内存单元管理单元之间。虚拟内存有很多用途与优点,它可以让

- 若干进程并发执行

- 应用程序所需内存大于可用物理内存时也可以运行

- 程序集有部分代码装入内存时进程可以执行

- 允许每个进程访问可用物理内存的子集进程

- 可以共享库数据或程序或函数等一个单独内存映像

- 程序是可定位的!也就是说我们可以把程序放在物理内存中的任何地方

- 程序员可以编写与机器无关的代码!因为他们根本不需要关心物理内存的组织结构,也就是说他把物理内存进行了一层抽象

虚拟内存子系统的主要成分是虚拟地址空间进程所用的一组内存地址。不同于物理内存地址!

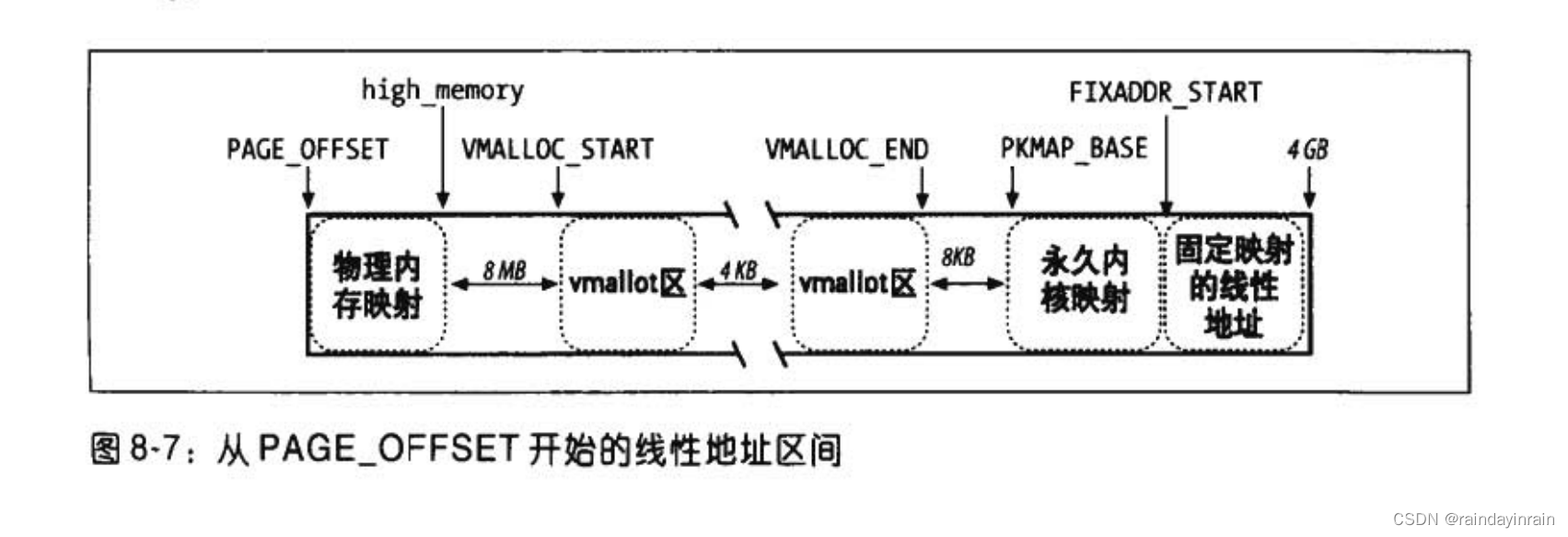

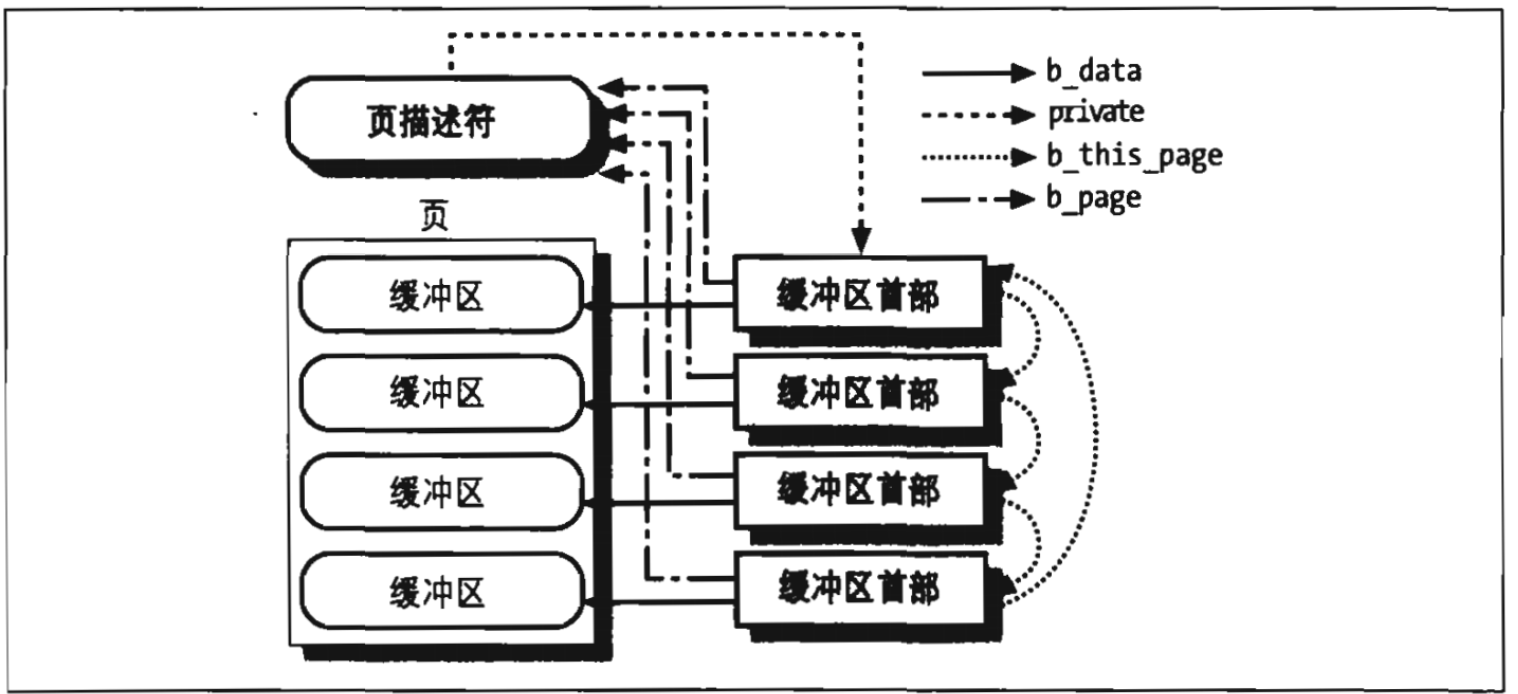

随机访问存储器的使用

随机访问存储器的使用分为两个部分:

一部分被专门用来存放内核映像,另一部分则由虚拟内存系统来进行处理:

- 用来满足内核对缓冲区描述服务及其它动态内核数据结构的请求

- 满足进程对一般性内存区的请求即对文件内存映射的请求

- 借助于高速缓存从磁盘或者其他缓冲设备获得较好的性能内存

内核分配器

它是一个子系统,试图满足系统中所有部分对内存的请求!其中一些请求可能来自内核其他子系统。他们需要一些内核使用的内存,还有一些请求则是来自用户程序的系统调用,以用来增加用户程序进程的地址空间!

一个好的内核内存分配器需要具有以下特点:

它必须快,实际上这是最重要的属性!因为它为所有的内核子系统所调用

必须把内存的浪费减到最少

必须努力减轻内存的碎片问题

必须能与其他内存管理子系统进行合作,以便借用和释放页框

现在已经提出了好几种内核内存分配器进程!这个可以查询其他资料!

进程的虚拟地址空间处理

进程的虚拟地址空间包括了进程可以引用的所有虚拟内存地址,内核通常用一组内存区描述符描述进程!虚拟地址空间内核分配给进程的虚拟地址空间主要有以下这几个部分:

- 组成程序的可执行代码

- 程序的初始化和未初始化的数据

- 初始程序栈

- 所需共享库的可执行代码和数据

- 堆

高速缓存

物理内存的一大优势就是用来磁盘和其它块设备的高速缓存!因为磁盘访问非常的慢,这与访问内存相比实在太长!因此磁盘通常是影响系统性能的一大瓶颈所在,最早的Unix系统中早就已经实现了一个策略就是对推迟写磁盘的时间,我们将在后续的实现中看看Linux是如何做到的!

内存寻址

引论,三个地址

下面来说说内存寻址!

程序员偶尔会引用内存地址作为访问内存单元的一种方式。我们有三种不同的地址:逻辑地址,线性地址,和物理地址

逻辑地址:指的是包含在机器语言指令中用来表示一个操作数或一条指令的地址!这种寻址方式在80X86著名的分段结构中表现得尤为具体,,它促使MSDOS程序员或Windows程序员把程序分成若干段(当然说的是汇编程序员hhh)。每一个逻辑地址都由一个段和偏移量组成!偏移量指明了从段开始的地方,到实际地址之间的距离

线性地址也被称为虚拟地址,是一个32位无符号整数(在32位平台上,自然的在64位平台上个就是64位无符号整数),可以用来表达高达4GB的地址!现行地址通常用16进制数字表示!

物理地址用来内存芯片及内存单元寻址。他们从与微处理器的地址引脚,发送到内存总线上的电信号。相对应物理地址由32位或36位无符号整数表示。内存控制单元通过一种分段单元的硬件电路把一个逻辑地址转换成一个线性地址,接着第二个称为分页单元的硬件电路把线性地址转换为一个物理地址!

硬件中的分段

从80286模型开始,英特尔微处理器以两种不同的方式执行地址转换这两种方式!分别被称为实模式和保护模式

段选择符和段寄存器一个逻辑地址有两个部分组成一个段标识符和一个段内相对地址的偏移量段标识符是一个16位长的字段也被称为段选择符为了快速方便地找到段选择符处理器提供一个叫做段寄存器的寄存器他的唯一目的是为了存放段选择符这些段寄存器被称为CS,SS,DS,ES,FS和GS。尽管只有六个段寄存器,但程序可以把同一个段的寄存器用作不同目的。方法是先把这个值保存在内存中,用完再恢复。其中有三者是有专门用途的。

CS(code segment):代码段寄存器!指向包含程序指令的段

SS(stack segmment):栈段寄存器!指向包含当前程序栈的段

DS(data segment):数据段寄存器!指向包含静态数据或者全局数据段!

CS寄存器还有一个重要的功能:它还有一个两位的字段用以指明CPU的当前特权级(Current Privilage Level)

值为零时代表最高优先级值!为三时表示最低优先级!Linux只用零级和三级,分别被称为内核态和用户态!

段描述符

每个段由八个字节的段描述符表示,他表示了一个段的特征!段描述符放在GDT或LDT中。通常只定义一个GDT而每个进程除了存放在GDP的段,以外如果还创建了附加的段,可以有自己的LDT。段序描述符字段由以下

| 标志 | 说明 |

|---|---|

| base | 表示段的首字节的线性地址 |

| G | 粒度标志!表示如果该位清零,则段大小以字节为单位。否则以4096字节的倍数。 |

| limit | 存放段中最后一个内存单元的偏移量,从而决定了段的长度。这就跟G扯上关系了: 如果既被置为零,则一个段的大小在1B到1MB之间变化,否则则在4KB到4GB之间变化 |

| S | 系统标志!如果它被清零则,这是一个系统段,存放着像LDT这种关键数据结构!否则它就是一个普通的代码段或数据段 |

| type | 描述了段的类型特征和它的存取权限 |

| DPL | 描述符特权级字段,用于限制这对这个段的存取!他表示为访问这个段要求的CPU最小优先级! |

| P | segment present标志!表示当前段并不在主存当中,Linux总是把这个标志设为一,因为他从不把整个段交换到磁盘上。 |

| D/B | 取决于是代码段还是数据段 |

| AVL | 系统使用但是已经被Linux所忽略 |

以下是Linux中被广泛使用的类型!

- 代码段描述符:表示这个段是一个代码段,它可以放在GDP或LDT中此时该描述符志S标志为一

- 数据段描述符:表示这个段描述了一个数据段,也可以被放在GDP或LDT中,S标志为1。栈段是通过一般的数据段所实现的!

- 任务状态的描述符:表示这个段的描述代表一个任务状态段,也就是TSS!这个段用来保存处理寄存器的内容

- 局部描述符表描述符:表示这个段描述符代表一个包含了LDT的段。他只会出现在GDT中!相应的type字段的值为2,S被置为零。

快速访问段描述符

我们回忆一下:逻辑地址是由一个16位段选择符和32位偏移量组成段寄存器!仅仅存放段选择符。为了加速逻辑地址到线性地址的转换,8086处理器提供了一种附加的非编程的寄存器:共六个可编程的段寄存器所使用。每一个非编程的寄存器含有八个字节的段描述符,由相应的段寄存器的段选择符来指定。每当一个段选择符被装入段寄存器时,相应的段描述符就从内存被装到对应的非编程CPU寄存器中!从那个时候起,针对那个段的逻辑地址转换就可以不用访问主存中的GDP或LDT。处理器只需要引用存放段描述符的CPU寄存器即可!仅当段寄存器的内容发生改变时,才会有必要访问GDP或LDT。这体现了一种缓存机制!

段选择符字段有三个字段名:

| 标识 | 说明 |

|---|---|

| index | 指定了放在GD T或LBT中的相应段描述符的一个入口 |

| TI | 指明断续描述符是在GDP中(TI = 0)还是在LDT中(TI = 1) |

| RPL | 请求者特权:即当相应的段选择符装入了CS寄存器中只是CPU当前的特权级!它还可以用来访问数据段时,有选择的削弱处理器的特权级分段单元。 |

分段单元

分段单元会执行以下操作:

- 它会检查段选择符的TI字段,以决定段描述符保存在哪一个描述符表中,TI字段指明段描述符市的GDP中还是在激活的LDT中

- 从段选择符的index字段中计算段描述符地址:index字段的值乘以八,这个结果与gdpr或ldtr寄存器中的内容相加。

- 把逻辑地址的偏移量与段描述符Base字段的值相加就会得到线性地址

Linux当中的分段是非常有限的!实际上分段和分页在某种程度上会显得有些多余,因为它们都可以划分进程的物理地址空间!分段可以给每一个进程分配以不同的线性空间,而分页则可以把同一线性地址空间映射到不同的物理内存。与分段相比,linux更青睐于使用分页方式:因为当所有进程使用相同的段寄存器值时,内存管理变得非常简单!也就是他们可以共享同样的一组线性地址!Linux的设计目标之一就是可以把它们移植到大多数流行的处理平台之下然而RISC体系结构对分段的支持非常有限!

Linux下的逻辑地址与线性地址是一致的:即逻辑地址的偏移量字段的值予以相应的线性地址的值总是一致的

Linux GDT

单处理器系统中只有一个GDT,而在多处理器系统中每个CPU对应一个GDT所。有的GDT都存放在cpu_gdt_table数组中:而所有GDP的地址和它们的大小(这个大小是初始化GDTR计算器使用)被存放在cpu_gdt_desp数组中!

每一个GDP的包含18个段分别指向下列的段:

- 用户态和内核态下的代码段和数数据段共四个任务状态段

- TSS,每个处理器有一个!

- 一个包含缺省局部描述符表的段,这个段是被所有进程共享的段!

- 三个局部线程存储段TLS,这种机制允许多线程应用程序使用最多三个局部与线程的数据段!

- 与高级电源管理相关的三个段

- 与支持即插即用功能的BIOS服务程序相关的五个段

- 被内核用来处理双重错误异常的特殊TSS段

Linux LDT

大多数Linux程序并不会使用局部描述符!然而在某些情况下进程仍然会需要创建自己的局部描述符表,比如说像Wine那样的程序

硬件中的分页

分页单元把线性地址转换为物理地址。其中一个关键的任务就是把请求的访问类型与线性地址的访问权限所相比较,如果这次访问是无效的,则会产生一个缺页异常!

为了效率,线性地址被分为固定长度为单位的组,称为页!页内不连续的线性地址会被映射到连续的物理地址当中去。这样内核可以指定一个页的物理地址和存取权限,而不用指定页所包含所有的线性地址的存取权限!我们通常遵循习惯使用习惯,让页来表示一组线性地址,包含这组地址中的数据。

分页单元把所有的分成固定长度的页框,有时也叫做物理页。每一个页框包含一个页,也就是说一个框的长度和一个页的长度是一致的。页框是主存的一部分,也就是存储区域。区分一个页和页框很重要,前者只是一个数据块,前者可以存放在任何页框和磁盘中。

把线性地址映射到物理地址的数据结构称为页表,页表存放在主存当中。并且启用分页单元之前就必须由内核对列表进行适当的初始化,从80386开始所有的值80X86处理器都会支持分页!它通过设置CR零寄存器的PG标志启用。当PG等于零时,线性地址就会被解释为物理地址。

32位线性地址经常会被分成三个域:

| directory目录 | table(页表) | offset偏移量 |

|---|---|---|

| 10 | 10 | 12 |

线性地址的转换分为两步走:每一步都基于一种转换表。第一种转换表被称为页目录表,第二种则是被称为页表。

使用这种二级模式的目的在于:减少每个进程页表所需要的RAM的数量!(自己想象如果给每一个信息地址的维护一个映射项的话这个页表将会有多么恐怖的大!)。页目录项和页表项有相同的结构!每项都包含下面的字段:

- present标志:如果被置为1,所指的页或页表它就在主存当中!如果该标志被置为零,则这一页并不在主存!当中如果执行一个地址转换所需的页表项或页目录项中的present被置为零,那么分页单元就会把该线性地址存放在控制寄存器CR2中,并产生14号异常缺页异常!操作系统会介入进行相应的处理。

- Field:包含页框物理地址最高二十位的字段!由于每一个页框有4kb标志的容量它的物理地址必须是4096的倍数,因此物理地址的最低12位总是零

- access:每当分页单元对应的页框进行寻址时,就会设置这个标志!当选中的页被交换出去,这个标志可以作系统所使用。分页单元从不会重置这个标志,而是必须由操作系统去做!

- read/write标志:含有页或页表的存取权限

- dirty标志:只用来列表项中每当对一个页框进行写操作时就会设置这个标识,当选中的页被交换出去,这个标志可以作系统所使用。分页单元从不会重置这个标志,而是必须由操作系统去做!

- user/supervisor标志:标志很有访问页或页表所需的特权级

- PCD和PWT标志:硬件控制硬件高速缓存处理页或页表的方式

- page size:只用于页目录项,如果被置为一则该目录页目录项指的是2mb或4mb的页框!

- global标识:只应用于页表项,这个标志是用来防止常用页从TLB高速缓存中刷新出去

PAE

常规分页机制32位地址线理论上可以寻址4GB的RAM地址空间。但是,大型的服务器需要大于4GB的RAM来同时运行数以千计的进程。

因此:Intel通过在处理器上把管脚数从32增加到36,以提高处理器的寻址能力,使其达到2^36=64GB,同时引入了一种新的分页机制PAE(Physical Address Extension,物理地址扩展)把32位线性地址转换为36位物理地址才能使用所增加的物理内存,通过设置CR4的第5位来开启对PAE的支持。引入PAE就是为了访问大于4GB的RAM,线性地址仍然是32位,而物理地址是36位。

把一个32位的虚拟地址分成4个部分:

- 0-11:页内偏移

- 12-20:页表(Page Table)

- 21-29:页表目录表(Page Table Directory)

- 30-31:页目录指针表(Page Directory Pointer Table)

硬件高速缓存

这是为了缓解微处理器的频率与访问RAM芯片的频率相差过大的矛盾所引入的!为了缩小CPU和RAM之间的速度不匹配,引入了硬件高速缓存内存机制:硬件高速缓存则是基于著名的局部性原理,该原理既适用于程序结构,也适用于数据结构!这表明由于程序的循环结构与相关数组可以组织成线性数组,最近最常用的相邻地址在最近的将来又被用到的可能性极大,因此引入小而快的内存来存放最近最常使用的代码和数据变得很有意义!

高速缓存又被细分为行的子集。在一种极端情况下高速缓存可以是直接映射的这是主存中的一个行,总是存放在高速缓存中完全相同的位置!在另一种极端情况下高速缓存是充分关联的,这意味着主存中的任意一个行,可以存放在高速缓存中的任意位置!

TLB

除了通用硬件高速缓存之外,还有一种转换后缓冲器或TLB的高速缓存用于加快线性地址转换

当线性地址第一次被使用时,通过慢速访问RAM中的页表,计算出相应的物理地址。同时物理地址被存放在一个TLB表象中,以便以后对同一个线性地址的引用时,得到快速的转换。

在多处理器系统中每个CPU都有自己的TLB这叫做CPU的本地TLB。与硬件高速缓存相反TLB的对应项不必同步,这是因为运行在现有CPU上可以使用同一个线性地址与不同的物理地址发生联系!

Linux中的分页

Linux从2.6开始使用四级分页:

- 页全局目录(Page Global Directory)

- 页上级目录(Page Upper Directory)

- 页中间目录(Page Middle Directory)

- 页表(Page Table)

页全局目录包含若干页上级目录的地址;

页上级目录又依次包含若干页中间目录的地址;

而页中间目录又包含若干页表的地址;

每一个页表项指向一个页框。

因此线性地址因此被分成五个部分,而每一部分的大小与具体的计算机体系结构有关。

页表类型定义pgd_t、pmd_t、pud_t和pte_t

Linux分别采用pgd_t、pmd_t、pud_t和pte_t四种数据结构来表示页全局目录项、页上级目录项、页中间目录项和页表项。这四种数据结构本质上都是无符号长整型unsigned long!

Linux为了更严格数据类型检查,将无符号长整型unsigned long分别封装成四种不同的页表项。如果不采用这种方法,那么一个无符号长整型数据可以传入任何一个与四种页表相关的函数或宏中,这将大大降低程序的健壮性。

pgprot_t是另一个64位(PAE激活时)或32位(PAE禁用时)的数据类型,它表示与一个单独表项相关的保护标志。

首先我们查看一下子这些类型是如何定义的

pteval_t,pmdval_t,pudval_t,pgdval_t

#ifndef __ASSEMBLY__

#include <linux/types.h>

/*

* These are used to make use of C type-checking..

*/

typedef unsigned long pteval_t;

typedef unsigned long pmdval_t;

typedef unsigned long pudval_t;

typedef unsigned long pgdval_t;

typedef unsigned long pgprotval_t;

typedef struct { pteval_t pte; } pte_t;

#endif /* !__ASSEMBLY__ */pgd_t、pmd_t、pud_t和pte_t

typedef struct { pgdval_t pgd; } pgd_t;

static inline pgd_t native_make_pgd(pgdval_t val)

{

return (pgd_t) { val };

}

static inline pgdval_t native_pgd_val(pgd_t pgd)

{

return pgd.pgd;

}

static inline pgdval_t pgd_flags(pgd_t pgd)

{

return native_pgd_val(pgd) & PTE_FLAGS_MASK;

}

#if CONFIG_PGTABLE_LEVELS > 3

typedef struct { pudval_t pud; } pud_t;

static inline pud_t native_make_pud(pmdval_t val)

{

return (pud_t) { val };

}

static inline pudval_t native_pud_val(pud_t pud)

{

return pud.pud;

}

#else

#include <asm-generic/pgtable-nopud.h>

static inline pudval_t native_pud_val(pud_t pud)

{

return native_pgd_val(pud.pgd);

}

#endif

#if CONFIG_PGTABLE_LEVELS > 2

typedef struct { pmdval_t pmd; } pmd_t;

static inline pmd_t native_make_pmd(pmdval_t val)

{

return (pmd_t) { val };

}

static inline pmdval_t native_pmd_val(pmd_t pmd)

{

return pmd.pmd;

}

#else

#include <asm-generic/pgtable-nopmd.h>

static inline pmdval_t native_pmd_val(pmd_t pmd)

{

return native_pgd_val(pmd.pud.pgd);

}

#endif

static inline pudval_t pud_pfn_mask(pud_t pud)

{

if (native_pud_val(pud) & _PAGE_PSE)

return PHYSICAL_PUD_PAGE_MASK;

else

return PTE_PFN_MASK;

}

static inline pudval_t pud_flags_mask(pud_t pud)

{

return ~pud_pfn_mask(pud);

}

static inline pudval_t pud_flags(pud_t pud)

{

return native_pud_val(pud) & pud_flags_mask(pud);

}

static inline pmdval_t pmd_pfn_mask(pmd_t pmd)

{

if (native_pmd_val(pmd) & _PAGE_PSE)

return PHYSICAL_PMD_PAGE_MASK;

else

return PTE_PFN_MASK;

}

static inline pmdval_t pmd_flags_mask(pmd_t pmd)

{

return ~pmd_pfn_mask(pmd);

}

static inline pmdval_t pmd_flags(pmd_t pmd)

{

return native_pmd_val(pmd) & pmd_flags_mask(pmd);

}

static inline pte_t native_make_pte(pteval_t val)

{

return (pte_t) { .pte = val };

}

static inline pteval_t native_pte_val(pte_t pte)

{

return pte.pte;

}

static inline pteval_t pte_flags(pte_t pte)

{

return native_pte_val(pte) & PTE_FLAGS_MASK;

}xxx_val和__xxx

五个类型转换宏(_ pte、_ pmd、_ pud、_ pgd和__ pgprot)把一个无符号整数转换成所需的类型。

另外的五个类型转换宏(pte_val,pmd_val, pud_val, pgd_val和pgprot_val)执行相反的转换,即把上面提到的四种特殊的类型转换成一个无符号整数。

#define pgd_val(x) native_pgd_val(x)

#define __pgd(x) native_make_pgd(x)

#ifndef __PAGETABLE_PUD_FOLDED

#define pud_val(x) native_pud_val(x)

#define __pud(x) native_make_pud(x)

#endif

#ifndef __PAGETABLE_PMD_FOLDED

#define pmd_val(x) native_pmd_val(x)

#define __pmd(x) native_make_pmd(x)

#endif

#define pte_val(x) native_pte_val(x)

#define __pte(x) native_make_pte(x) 这里需要区别指向页表项的指针和页表项所代表的数据。以pgd_t类型为例子,如果已知一个pgd_t类型的指针pgd,那么通过pgd_val(*pgd)即可获得该页表项(也就是一个无符号长整型数据),这里利用了面向对象的思想。

页表描述宏

参照arch/x86/include/asm/pgtable_64

linux中使用下列宏简化了页表处理,对于每一级页表都使用有以下三个关键描述宏:

| 宏字段 | 描述 |

|---|---|

| XXX_SHIFT | 指定Offset字段的位数 |

| XXX_SIZE | 页的大小 |

| XXX_MASK | 用以屏蔽Offset字段的所有位。 |

我们的四级页表,对应的宏分别由PAGE,PMD,PUD,PGDIR

| 宏字段前缀 | 描述 |

|---|---|

| PGDIR | 页全局目录(Page Global Directory) |

| PUD | 页上级目录(Page Upper Directory) |

| PMD | 页中间目录(Page Middle Directory) |

| PAGE | 页表(Page Table) |

PAGE宏–页表(Page Table)

| 字段 | 描述 |

|---|---|

| PAGE_SHIFT | 指定Offset字段的位数 |

| PAGE_SIZE | 页的大小 |

| PAGE_MASK | 用以屏蔽Offset字段的所有位。 |

定义如下,在/arch/x86/include/asm/page_types.h文件中

/* PAGE_SHIFT determines the page size */

#define PAGE_SHIFT 12

#define PAGE_SIZE (_AC(1,UL) << PAGE_SHIFT)

#define PAGE_MASK (~(PAGE_SIZE-1))当用于80x86处理器时,PAGE_SHIFT返回的值为12。

由于页内所有地址都必须放在Offset字段, 因此80x86系统的页的大小PAGE_SIZE是2^12=4096字节。

PAGE_MASK宏产生的值为0xfffff000,用以屏蔽Offset字段的所有位。

PMD-Page Middle Directory (页目录)

| 字段 | 描述 |

|---|---|

| PMD_SHIFT | 指定线性地址的Offset和Table字段的总位数;换句话说,是页中间目录项可以映射的区域大小的对数 |

| PMD_SIZE | 用于计算由页中间目录的一个单独表项所映射的区域大小,也就是一个页表的大小 |

| PMD_MASK | 用于屏蔽Offset字段与Table字段的所有位 |

当PAE 被禁用时,PMD_SHIFT 产生的值为22(来自Offset 的12 位加上来自Table 的10 位),

PMD_SIZE 产生的值为222 或 4 MB,

PMD_MASK产生的值为 0xffc00000。

相反,当PAE被激活时,

PMD_SHIFT 产生的值为21 (来自Offset的12位加上来自Table的9位),

PMD_SIZE 产生的值为2^21 或2 MB

PMD_MASK产生的值为 0xffe00000。

大型页不使用最后一级页表,所以产生大型页尺寸的LARGE_PAGE_SIZE 宏等于PMD_SIZE(2PMD_SHIFT),而在大型页地址中用于屏蔽Offset字段和Table字段的所有位的LARGE_PAGE_MASK宏,就等于PMD_MASK。

PUD_SHIFT-页上级目录(Page Upper Directory)

| 字段 | 描述 |

|---|---|

| PUD_SHIFT | 确定页上级目录项能映射的区域大小的位数 |

| PUD_SIZE | 用于计算页全局目录中的一个单独表项所能映射的区域大小。 |

| PUD_MASK | 用于屏蔽Offset字段,Table字段,Middle Air字段和Upper Air字段的所有位 |

在80x86处理器上,PUD_SHIFT总是等价于PMD_SHIFT,而PUD_SIZE则等于4MB或2MB。

PGDIR_SHIFT-页全局目录(Page Global Directory)

| 字段 | 描述 |

|---|---|

| PGDIR_SHIFT | 确定页全局页目录项能映射的区域大小的位数 |

| PGDIR_SIZE | 用于计算页全局目录中一个单独表项所能映射区域的大小 |

| PGDIR_MASK | 用于屏蔽Offset, Table,Middle Air及Upper Air的所有位 |

当PAE 被禁止时,

PGDIR_SHIFT 产生的值为22(与PMD_SHIFT 和PUD_SHIFT 产生的值相同),

PGDIR_SIZE 产生的值为 222 或 4 MB,

PGDIR_MASK 产生的值为 0xffc00000。

相反,当PAE被激活时,

PGDIR_SHIFT 产生的值为30 (12 位Offset 加 9 位Table再加 9位 Middle Air),

PGDIR_SIZE 产生的值为230 或 1 GB

PGDIR_MASK产生的值为0xc0000000

PTRS_PER_PTE, PTRS_PER_PMD, PTRS_PER_PUD以及PTRS_PER_PGD

用于计算页表、页中间目录、页上级目录和页全局目录表中表项的个数。当PAE被禁止时,它们产生的值分别为1024,1,1和1024。当PAE被激活时,产生的值分别为512,512,1和4。

页表处理函数

内核还提供了许多宏和函数用于读或修改页表表项:

- 如果相应的表项值为0,那么,宏pte_none、pmd_none、pud_none和 pgd_none产生的值为1,否则产生的值为0。

- 宏pte_clear、pmd_clear、pud_clear和 pgd_clear清除相应页表的一个表项,由此禁止进程使用由该页表项映射的线性地址。ptep_get_and_clear( )函数清除一个页表项并返回前一个值。

- set_pte,set_pmd,set_pud和set_pgd向一个页表项中写入指定的值。set_pte_atomic与set_pte作用相同,但是当PAE被激活时它同样能保证64位的值能被原子地写入。

- 如果a和b两个页表项指向同一页并且指定相同访问优先级,pte_same(a,b)返回1,否则返回0。

- 如果页中间目录项指向一个大型页(2MB或4MB),pmd_large(e)返回1,否则返回0。

宏pmd_bad由函数使用并通过输入参数传递来检查页中间目录项。如果目录项指向一个不能使用的页表,也就是说,如果至少出现以下条件中的一个,则这个宏产生的值为1:

- 页不在主存中(Present标志被清除)。

- 页只允许读访问(Read/Write标志被清除)。

- Acessed或者Dirty位被清除(对于每个现有的页表,Linux总是

强制设置这些标志)。

pud_bad宏和pgd_bad宏总是产生0。没有定义pte_bad宏,因为页表项引用一个不在主存中的页,一个不可写的页或一个根本无法访问的页都是合法的。

如果一个页表项的Present标志或者Page Size标志等于1,则pte_present宏产生的值为1,否则为0。

前面讲过页表项的Page Size标志对微处理器的分页部件来讲没有意义,然而,对于当前在主存中却又没有读、写或执行权限的页,内核将其Present和Page Size分别标记为0和1。

这样,任何试图对此类页的访问都会引起一个缺页异常,因为页的Present标志被清0,而内核可以通过检查Page Size的值来检测到产生异常并不是因为缺页。

如果相应表项的Present标志等于1,也就是说,如果对应的页或页表被装载入主存,pmd_present宏产生的值为1。pud_present宏和pgd_present宏产生的值总是1。

查询页表项中任意一个标志的当前值

下表中列出的函数用来查询页表项中任意一个标志的当前值;除了pte_file()外,其他函数只有在pte_present返回1的时候,才能正常返回页表项中任意一个标志。

| 函数名称 | 说明 |

|---|---|

| pte_user( ) | 读 User/Supervisor 标志 |

| pte_read( ) | 读 User/Supervisor 标志(表示 80x86 处理器上的页不受读的保护) |

| pte_write( ) | 读 Read/Write 标志 |

| pte_exec( ) | 读 User/Supervisor 标志( 80x86 处理器上的页不受代码执行的保护) |

| pte_dirty( ) | 读 Dirty 标志 |

| pte_young( ) | 读 Accessed 标志 |

| pte_file( ) | 读 Dirty 标志(当 Present 标志被清除而 Dirty 标志被设置时,页属于一个非线性磁盘文件映射) |

2.3.2 设置页表项中各标志的值

下表列出的另一组函数用于设置页表项中各标志的值

| 函数名称 | 说明 |

|---|---|

| mk_pte_huge( ) | 设置页表项中的 Page Size 和 Present 标志 |

| pte_wrprotect( ) | 清除 Read/Write 标志 |

| pte_rdprotect( ) | 清除 User/Supervisor 标志 |

| pte_exprotect( ) | 清除 User/Supervisor 标志 |

| pte_mkwrite( ) | 设置 Read/Write 标志 |

| pte_mkread( ) | 设置 User/Supervisor 标志 |

| pte_mkexec( ) | 设置 User/Supervisor 标志 |

| pte_mkclean( ) | 清除 Dirty 标志 |

| pte_mkdirty( ) | 设置 Dirty 标志 |

| pte_mkold( ) | 清除 Accessed 标志(把此页标记为未访问) |

| pte_mkyoung( ) | 设置 Accessed 标志(把此页标记为访问过) |

| pte_modify(p,v) | 把页表项 p 的所有访问权限设置为指定的值 |

| ptep_set_wrprotect() | 与 pte_wrprotect( ) 类似,但作用于指向页表项的指针 |

| ptep_set_access_flags( ) | 如果 Dirty 标志被设置为 1 则将页的访问权设置为指定的值,并调用flush_tlb_page() 函数 |

| ptep_mkdirty() | 与 pte_mkdirty( ) 类似,但作用于指向页表项的指针。 |

| ptep_test_and_clear_dirty( ) | 与 pte_mkclean( ) 类似,但作用于指向页表项的指针并返回 Dirty 标志的旧值 |

| ptep_test_and_clear_young( ) | 与 pte_mkold( ) 类似,但作用于指向页表项的指针并返回 Accessed标志的旧值 |

宏函数-把一个页地址和一组保护标志组合成页表项,或者执行相反的操作

现在,我们来讨论下表中列出的宏,它们把一个页地址和一组保护标志组合成页表项,或者执行相反的操作,从一个页表项中提取出页地址。请注意这其中的一些宏对页的引用是通过 “页描述符”的线性地址,而不是通过该页本身的线性地址。

| 宏名称 | 说明 |

|---|---|

| pgd_index(addr) | 找到线性地址 addr 对应的的目录项在页全局目录中的索引(相对位置) |

| pgd_offset(mm, addr) | 接收内存描述符地址 mm 和线性地址 addr 作为参数。这个宏产生地址addr 在页全局目录中相应表项的线性地址;通过内存描述符 mm 内的一个指针可以找到这个页全局目录 |

| pgd_offset_k(addr) | 产生主内核页全局目录中的某个项的线性地址,该项对应于地址 addr |

| pgd_page(pgd) | 通过页全局目录项 pgd 产生页上级目录所在页框的页描述符地址。在两级或三级分页系统中,该宏等价于 pud_page() ,后者应用于页上级目录项 |

| pud_offset(pgd, addr) | 参数为指向页全局目录项的指针 pgd 和线性地址 addr 。这个宏产生页上级目录中目录项 addr 对应的线性地址。在两级或三级分页系统中,该宏产生 pgd ,即一个页全局目录项的地址 |

| pud_page(pud) | 通过页上级目录项 pud 产生相应的页中间目录的线性地址。在两级分页系统中,该宏等价于 pmd_page() ,后者应用于页中间目录项 |

| pmd_index(addr) | 产生线性地址 addr 在页中间目录中所对应目录项的索引(相对位置) |

| pmd_offset(pud, addr) | 接收指向页上级目录项的指针 pud 和线性地址 addr 作为参数。这个宏产生目录项 addr 在页中间目录中的偏移地址。在两级或三级分页系统中,它产生 pud ,即页全局目录项的地址 |

| pmd_page(pmd) | 通过页中间目录项 pmd 产生相应页表的页描述符地址。在两级或三级分页系统中, pmd 实际上是页全局目录中的一项 |

| mk_pte(p,prot) | 接收页描述符地址 p 和一组访问权限 prot 作为参数,并创建相应的页表项 |

| pte_index(addr) | 产生线性地址 addr 对应的表项在页表中的索引(相对位置) |

| pte_offset_kernel(dir,addr) | 线性地址 addr 在页中间目录 dir 中有一个对应的项,该宏就产生这个对应项,即页表的线性地址。另外,该宏只在主内核页表上使用 |

| pte_offset_map(dir, addr) | 接收指向一个页中间目录项的指针 dir 和线性地址 addr 作为参数,它产生与线性地址 addr 相对应的页表项的线性地址。如果页表被保存在高端存储器中,那么内核建立一个临时内核映射,并用 pte_unmap 对它进行释放。 pte_offset_map_nested 宏和 pte_unmap_nested 宏是相同的,但它们使用不同的临时内核映射 |

| pte_page( x ) | 返回页表项 x 所引用页的描述符地址 |

| pte_to_pgoff( pte ) | 从一个页表项的 pte 字段内容中提取出文件偏移量,这个偏移量对应着一个非线性文件内存映射所在的页 |

| pgoff_to_pte(offset ) | 为非线性文件内存映射所在的页创建对应页表项的内容 |

简化页表项的创建和撤消

下面我们罗列最后一组函数来简化页表项的创建和撤消。当使用两级页表时,创建或删除一个页中间目录项是不重要的。如本节前部分所述,页中间目录仅含有一个指向下属页表的目录项。所以,页中间目录项只是页全局目录中的一项而已。然而当处理页表时,创建一个页表项可能很复杂,因为包含页表项的那个页表可能就不存在。在这样的情况下,有必要分配一个新页框,把它填写为 0 ,并把这个表项加入。

如果 PAE 被激活,内核使用三级页表。当内核创建一个新的页全局目录时,同时也分配四个相应的页中间目录;只有当父页全局目录被释放时,这四个页中间目录才得以释放。当使用两级或三级分页时,页上级目录项总是被映射为页全局目录中的一个单独项。与以往一样,下表中列出的函数描述是针对 80x86 构架的。

| 函数名称 | 说明 |

|---|---|

| pgd_alloc( mm ) | 分配一个新的页全局目录。如果 PAE 被激活,它还分配三个对应用户态线性地址的子页中间目录。参数 mm( 内存描述符的地址 )在 80x86 构架上被忽略 |

| pgd_free( pgd) | 释放页全局目录中地址为 pgd 的项。如果 PAE 被激活,它还将释放用户态线性地址对应的三个页中间目录 |

| pud_alloc(mm, pgd, addr) | 在两级或三级分页系统下,这个函数什么也不做:它仅仅返回页全局目录项 pgd 的线性地址 |

| pud_free(x) | 在两级或三级分页系统下,这个宏什么也不做 |

| pmd_alloc(mm, pud, addr) | 定义这个函数以使普通三级分页系统可以为线性地址 addr 分配一个新的页中间目录。如果 PAE 未被激活,这个函数只是返回输入参数 pud 的值,也就是说,返回页全局目录中目录项的地址。如果 PAE 被激活,该函数返回线性地址 addr 对应的页中间目录项的线性地址。参数 mm 被忽略 |

| pmd_free(x) | 该函数什么也不做,因为页中间目录的分配和释放是随同它们的父全局目录一同进行的 |

| pte_alloc_map(mm, pmd, addr) | 接收页中间目录项的地址 pmd 和线性地址 addr 作为参数,并返回与 addr 对应的页表项的地址。如果页中间目录项为空,该函数通过调用函数 pte_alloc_one( ) 分配一个新页表。如果分配了一个新页表, addr 对应的项就被创建,同时 User/Supervisor 标志被设置为 1 。如果页表被保存在高端内存,则内核建立一个临时内核映射,并用 pte_unmap 对它进行释放 |

| pte_alloc_kernel(mm, pmd, addr) | 如果与地址 addr 相关的页中间目录项 pmd 为空,该函数分配一个新页表。然后返回与 addr 相关的页表项的线性地址。该函数仅被主内核页表使用 |

| pte_free(pte) | 释放与页描述符指针 pte 相关的页表 |

| pte_free_kernel(pte) | 等价于 pte_free( ) ,但由主内核页表使用 |

| clear_page_range(mmu, start,end) | 从线性地址 start 到 end 通过反复释放页表和清除页中间目录项来清除进程页表的内容 |

处理硬件高速缓存与TLB

void flush_tlb_all(void)最严格的刷新。在这个接口运行后,任何以前的页表修改都会对cpu可见。

这通常是在内核页表被改变时调用的,因为这种转换在本质上是“全局”的。

void flush_tlb_mm(struct mm_struct *mm)这个接口从TLB中刷新整个用户地址空间。在运行后,这个接口必须确保 以前对地址空间‘mm’的任何页表修改对cpu来说是可见的。也就是说,在 运行后,TLB中不会有‘mm’的页表项。

这个接口被用来处理整个地址空间的页表操作,比如在fork和exec过程 中发生的事情。

void flush_tlb_range(struct vm_area_struct *vma, unsigned long start, unsigned long end)这里我们要从TLB中刷新一个特定范围的(用户)虚拟地址转换。在运行后, 这个接口必须确保以前对‘start’到‘end-1’范围内的地址空间‘vma->vm_mm’ 的任何页表修改对cpu来说是可见的。也就是说,在运行后,TLB中不会有 ‘mm’的页表项用于‘start’到‘end-1’范围内的虚拟地址。

“vma”是用于该区域的备份存储。主要是用于munmap()类型的操作。

提供这个接口是希望端口能够找到一个合适的有效方法来从TLB中删除多 个页面大小的转换,而不是让内核为每个可能被修改的页表项调用 flush_tlb_page(见下文)。

void flush_tlb_page(struct vm_area_struct *vma, unsigned long addr)这一次我们需要从TLB中删除PAGE_SIZE大小的转换。‘vma’是Linux用来跟 踪进程的mmap区域的支持结构体,地址空间可以通过vma->vm_mm获得。另 外,可以通过测试(vma->vm_flags & VM_EXEC)来查看这个区域是否是 可执行的(因此在split-tlb类型的设置中可能在“指令TLB”中)。

在运行后,这个接口必须确保之前对用户虚拟地址“addr”的地址空间 “vma->vm_mm”的页表修改对cpu来说是可见的。也就是说,在运行后,TLB 中不会有虚拟地址‘addr’的‘vma->vm_mm’的页表项。

这主要是在故障处理时使用。

void update_mmu_cache(struct vm_area_struct *vma, unsigned long address, pte_t *ptep)在每个缺页异常结束时,这个程序被调用,以告诉体系结构特定的代码,在 软件页表中,在地址空间“vma->vm_mm”的虚拟地址“地址”处,现在存在 一个翻译。

可以用它所选择的任何方式使用这个信息来进行移植。例如,它可以使用这 个事件来为软件管理的TLB配置预装TLB转换。目前sparc64移植就是这么干 的。

接下来,我们有缓存刷新接口。一般来说,当Linux将现有的虚拟->物理映射 改变为新的值时,其顺序将是以下形式之一:

1) flush_cache_mm(mm);

change_all_page_tables_of(mm);

flush_tlb_mm(mm);

2) flush_cache_range(vma, start, end);

change_range_of_page_tables(mm, start, end);

flush_tlb_range(vma, start, end);

3) flush_cache_page(vma, addr, pfn);

set_pte(pte_pointer, new_pte_val);

flush_tlb_page(vma, addr); 缓存级别的刷新将永远是第一位的,因为这允许我们正确处理那些缓存严格, 且在虚拟地址被从缓存中刷新时要求一个虚拟地址的虚拟->物理转换存在的系统。 HyperSparc cpu就是这样一个具有这种属性的cpu。

下面的缓存刷新程序只需要在特定的cpu需要的范围内处理缓存刷新。大多数 情况下,这些程序必须为cpu实现,这些cpu有虚拟索引的缓存,当虚拟->物 理转换被改变或移除时:必须被刷新。因此,例如,IA32处理器的物理索引的物理标记的缓存没有必要实现这些接口,因为这些缓存是完全同步的,并且不依赖于翻译信息。

下面逐个列出这些程序:

void flush_cache_mm(struct mm_struct *mm)这个接口将整个用户地址空间从高速缓存中刷掉。也就是说,在运行后, 将没有与‘mm’相关的缓存行。

这个接口被用来处理整个地址空间的页表操作,比如在退出和执行过程 中发生的事情。

void flush_cache_dup_mm(struct mm_struct *mm)这个接口将整个用户地址空间从高速缓存中刷新掉。也就是说,在运行 后,将没有与‘mm’相关的缓存行。

这个接口被用来处理整个地址空间的页表操作,比如在fork过程中发生 的事情。

这个选项与flush_cache_mm分开,以允许对VIPT缓存进行一些优化。

void flush_cache_range(struct vm_area_struct *vma, unsigned long start, unsigned long end)在这里,我们要从缓存中刷新一个特定范围的(用户)虚拟地址。运行 后,在“start”到“end-1”范围内的虚拟地址的“vma->vm_mm”的缓存中 将没有页表项。

“vma”是被用于该区域的备份存储。主要是用于munmap()类型的操作。

提供这个接口是希望端口能够找到一个合适的有效方法来从缓存中删 除多个页面大小的区域, 而不是让内核为每个可能被修改的页表项调 用 flush_cache_page (见下文)。

void flush_cache_page(struct vm_area_struct *vma, unsigned long addr, unsigned long pfn)这一次我们需要从缓存中删除一个PAGE_SIZE大小的区域。“vma”是 Linux用来跟踪进程的mmap区域的支持结构体,地址空间可以通过 vma->vm_mm获得。另外,我们可以通过测试(vma->vm_flags & VM_EXEC)来查看这个区域是否是可执行的(因此在“Harvard”类 型的缓存布局中可能是在“指令缓存”中)。

“pfn”表示“addr”所对应的物理页框(通过PAGE_SHIFT左移这个 值来获得物理地址)。正是这个映射应该从缓存中删除。

在运行之后,对于虚拟地址‘addr’的‘vma->vm_mm’,在缓存中不会 有任何页表项,它被翻译成‘pfn’。

这主要是在故障处理过程中使用。

void flush_cache_kmaps(void)只有在平台使用高位内存的情况下才需要实现这个程序。它将在所有的 kmaps失效之前被调用。

运行后,内核虚拟地址范围PKMAP_ADDR(0)到PKMAP_ADDR(LAST_PKMAP) 的缓存中将没有页表项。

这个程序应该在asm/highmem.h中实现。

void flush_cache_vmap(unsigned long start, unsigned long end)void flush_cache_vunmap(unsigned long start, unsigned long end)在这里,在这两个接口中,我们从缓存中刷新一个特定范围的(内核) 虚拟地址。运行后,在“start”到“end-1”范围内的虚拟地址的内核地 址空间的缓存中不会有页表项。

这两个程序中的第一个是在vmap_range()安装了页表项之后调用的。 第二个是在vunmap_range()删除页表项之前调用的。

这是处理页表的一些API:

void copy_user_page(void *to, void *from, unsigned long addr, struct page *page)` `void clear_user_page(void *to, unsigned long addr, struct page *page)这两个程序在用户匿名或COW页中存储数据。它允许一个端口有效地 避免用户空间和内核之间的D-cache别名问题。

例如,一个端口可以在复制过程中把“from”和“to”暂时映射到内核 的虚拟地址上。这两个页面的虚拟地址的选择方式是,内核的加载/存 储指令发生在虚拟地址上,而这些虚拟地址与用户的页面映射是相同 的“颜色”。例如,Sparc64就使用这种技术。

“addr”参数告诉了用户最终要映射这个页面的虚拟地址,“page”参 数给出了一个指向目标页结构体的指针。

如果D-cache别名不是问题,这两个程序可以简单地直接调用 memcpy/memset而不做其他事情。

void flush_dcache_page(struct page *page)任何时候,当内核写到一个页面缓存页,或者内核要从一个页面缓存页中读出,并且这个页面的用户空间共享/可写映射可能存在时, 这个程序就会被调用。

这个程序只需要为有可能被映射到用户进程的地址空间的 页面缓存调用。因此,例如,处理页面缓存中vfs符号链 接的VFS层代码根本不需要调用这个接口。“内核写入页面缓存的页面”这句话的意思是,具体来说,内核执行存 储指令,在该页面的页面->虚拟映射处弄脏该页面的数据。在这里,通 过刷新的手段处理D-cache的别名是很重要的,以确保这些内核存储对 该页的用户空间映射是可见的。推论的情况也同样重要,如果有用户对这个文件有共享+可写的映射, 我们必须确保内核对这些页面的读取会看到用户所做的最新的存储。

如果D-cache别名不是一个问题,这个程序可以简单地定义为该架构上 的nop。在page->flags (PG_arch_1)中有一个位是“架构私有”。内核保证, 对于分页缓存的页面,当这样的页面第一次进入分页缓存时,它将清除这个位。这使得这些接口可以更有效地被实现。如果目前没有用户进程映射这个 页面,它允许我们“推迟”(也许是无限期)实际的刷新过程。请看 sparc64的flush_dcache_page和update_mmu_cache实现,以了解如 何做到这一点。

这个想法是,首先在flush_dcache_page()时,如果page->mapping->i_mmap 是一个空树,只需标记架构私有页标志位。之后,在update_mmu_cache() 中,会对这个标志位进行检查,如果设置了,就进行刷新,并清除标志位。通常很重要的是,如果你推迟刷新,实际的刷新发生在同一个 CPU上,因为它将cpu存储到页面上,使其变脏。同样,请看 sparc64关于如何处理这个问题的例子。

void flush_dcache_folio(struct folio *folio)该函数的调用情形与flush_dcache_page()相同。它允许架构针对刷新整个 folio页面进行优化,而不是一次刷新一页。

void copy_to_user_page(struct vm_area_struct *vma, struct page *page, unsigned long user_vaddr, void *dst, void *src, int len)` `void copy_from_user_page(struct vm_area_struct *vma, struct page *page, unsigned long user_vaddr, void *dst, void *src, int len)当内核需要复制任意的数据进出任意的用户页时(比如ptrace()),它将使 用这两个程序。

任何必要的缓存刷新或其他需要发生的一致性操作都应该在这里发生。如果 处理器的指令缓存没有对cpu存储进行窥探,那么你很可能需要为 copy_to_user_page()刷新指令缓存。

void flush_anon_page(struct vm_area_struct *vma, struct page *page, unsigned long vmaddr)当内核需要访问一个匿名页的内容时,它会调用这个函数(目前只有 get_user_pages())。注意:flush_dcache_page()故意对匿名页不起作 用。默认的实现是nop(对于所有相干的架构应该保持这样)。对于不一致性 的架构,它应该刷新vmaddr处的页面缓存。

void flush_icache_range(unsigned long start, unsigned long end)当内核存储到它将执行的地址中时(例如在加载模块时),这个函数被调用。

如果icache不对存储进行窥探,那么这个程序将需要对其进行刷新。

void flush_icache_page(struct vm_area_struct *vma, struct page *page)flush_icache_page的所有功能都可以在flush_dcache_page和update_mmu_cache 中实现。在未来,我们希望能够完全删除这个接口。

最后一类API是用于I/O到内核内特意设置的别名地址范围。这种别名是通过使用 vmap/vmalloc API设置的。由于内核I/O是通过物理页进行的,I/O子系统假定用户 映射和内核偏移映射是唯一的别名。这对vmap别名来说是不正确的,所以内核中任何 试图对vmap区域进行I/O的东西都必须手动管理一致性。它必须在做I/O之前刷新vmap 范围,并在I/O返回后使其失效。

void flush_kernel_vmap_range(void *vaddr, int size)刷新vmap区域中指定的虚拟地址范围的内核缓存。这是为了确保内核在vmap范围 内修改的任何数据对物理页是可见的。这个设计是为了使这个区域可以安全地执 行I/O。注意,这个API并 没有 刷新该区域的偏移映射别名。

void invalidate_kernel_vmap_range(void *vaddr, int size) invalidates在vmap区域的一个给定的虚拟地址范围的缓存,这可以防止处理器在物理页的I/O 发生时通过投机性地读取数据而使缓存变脏。这只对读入vmap区域的数据是必要的。

Reference

物理地址扩展(PAE)分页机制 - 冷烟花 - 博客园 (cnblogs。com)分页机制 常规分页机制32位地址线理论上可以寻址4GB的RAM地址空间%2C但是%2C大型的服务器需要大雨4GB的RAM来同时运行数以千计的进程%2C因此%2CIntel通过在处理器上把管脚数从32增加到36%2C以提高处理器的寻址能力%2C使其达到2^36%3D64GB%2C同时引入了一种新的分页机制PAE,(Physical Address Extension%2C物理地址扩展)把32位线性地址转换为36位物理地址才能使用所增加的物理内存%2C通过设置CR4的第5位来开启对PAE的支持。引入PAE就是为了访问大于4GB的RAM%2C线性地址仍然是32位%2C而物理地址是36位。)

PAE 分页模式详解 - jack。chen - 博客园 (cnblogs。com)

Linux分页机制之分页机制的实现详解—Linux内存管理(八) - yooooooo - 博客园 (cnblogs.com)

进程

下面开始讨论一个非常重要的抽象:这在我们前边已经提到过了的!也就是进程!

进程在使用中常有几个不同的含义,比如说在一般的操作系统教科书中给出了通用定义是:

进程是程序执行的一个实例

进程就像生命一般他们被产生,有或多或少的有效生命周期,,可以产生一个或者多个子进程,但是它们最终都会死亡!从内核观点上看进程的目的就是分配系统资源的一个实体

当一个进程创建时,它几乎与父进程相同。它接收父进程地址空间的一个逻辑拷贝,并开始执行父进程相同的代码!

Linux使用轻量级进程,对多线程应用程序提供了更好的支持。两个轻量级进程基本上可以共享一些资源诸如打开的文件,地址空间等。只要其中一个修改了共享资源,另一个就立即查看各种修改

进程描述符

为了管理进程,内核必须对每个进程所做的事情有清楚的描述!

首先我们要看的是进程的状态:顾名思义当我们查看源码时,进程描述符中的state字段就描述了进程当前的状态。它由一组标志组成。有以下几种可能的状态:

- 可运行状态(TASK_RUNNING):其进程要么在CPU上执行要么准备执行与

- 可中断的等待状态(TASK_INTERRUPTIBLE):进程被挂起直到某个条件为真,产生一个硬件中断,释放进程,正等待的系统资源或传递一个信号都是可以唤醒进程的条件

- 不可中断的等待状态(TASK_UNINTERRUPTIBLE):与可中断的等待状态类似,但是有一个例外:把信号传递到睡眠进程不能改变它的状态。这种状态很少用到,但在一些特定的情况下,也就是要求进程必须等待直到一个不能被中断的事件发生时,这种状态很有用!例如当进程打开一个设备文件,设备驱动程序开始探测相应的硬件设备时会用到这个状态,探测完成以前设备驱动程序是不可以被中断的!否则硬件设备会处于一种不可预知的状态!

- 暂停状态(TASK_STOPPED):进程的执行被暂停,当进程接收到这四个信号:SIGSTOP,SIGTSTP,SIGTTIN,SIGTTOU,进入暂停状态

- 跟踪状态(TASK_TRACED):进程的执行已经被调试程序暂停,当一个进程被另一个进程监控时,任何信号都可以把这个进程置于这个状态!

还有两个进程状态,是既可以存放在进程描述符当中,,也可以存放在退出状态字段当中!

- 僵死状态:进程的执行被终止,但是父进程并没有发布wait4或wait pid系统调用来返回有关死亡进程的信息

- 将死撤销状态:最终状态由于父进程发出了上面提到的两个系统调用,因而进程由系统进行删除。为了防止其他执行进程在同一进程上也执行wait类系统调用而把进程的状态由僵死状态设为僵死撤销状态!

标识一个进程

一般来说能被独立调度的每个进程上下文都必须有它自己的进程描述符!也就是pid。pid存放在进程描述符的pid字段中,它被顺序编号。内核使用一个pid_map_array位图来表示当前已经被分配的pid号和闲置的pid号。

进程描述符处理进程是动态实体,因此内核必须能够同时处理很多进程!并把进程描述符存放在动态内存中,而不是永久分配给内核的内存区!

标识当前进程是使用一个叫做thread_info的结构。进程最常用地址不是thread_info地址而是进程描述符的地址,为了获得当前CPU上运行形成的描述符指针内核需要调用current宏。该宏本质上等价于current thread info()->task

进程组织

Linux使用双向链表来管理进程!被称为进程链表。

task_running状态的进程列表,当内核寻找一个新进程在CPU上运行时,必须只考虑可以运行的。进程在Linux 2.6实现的运行队列与之前的实现有所不同,其目的是让调度程序能够在固定时间内选出最佳的可知运行进程!与队列中的可运行的进程数无关

进程之间的关系

程序创建的进程具有父子关系。如果一个进程创建多个子进程,则多个子进程之间又有兄弟关系。进程描述符中表示进程亲属关系的字段描述如下:

| 描述符 | 说明 |

|---|---|

| real parent | 指向创建了P的进程的描述符,如果P的进程不再存在就指向进程init进程描述符 |

| parent | P的当前父进程,它的值通常与real parent一致。但偶尔有所不同,比如说另一个进程发出监控P的Ptrace调用时。 |

| Children | 链表的头部链表中的所有元素都是P创建的子进程 |

| sibling | 指向兄弟进程链表中的下一个元素,或前一个元素的指针。这些兄弟进程的父进程都是P |

如何组织进程

运行队列链表把处于task running状态的所有进程组织在,一起不同的状态要求不同的处理!Linux选择下面的方式之一:

没有未处理task_stopped和exit_zombie或者是exit_dead状态的进程建立专门的链表。由于对处于暂停僵死,死亡状态进程的访问比较简单,或者通过pid或者通过特定父进程的子进程链表。所以不必对这三种状态进行分组

根据不同的特殊事件把处于task_interrupttable或task_uninterruptable状态的进程细分为许多类,每个类都对应一个特殊事件。

在这种情况下进程状态提供的信息满足不了快速检索进程的需要,所以需要另外引入进程列表!

等待队列

等待队列在内核中有很多用途!特别是在处理中断处理进程同步及定时(进程必须经常等待某些事情的发生——等待队列是由双向链表所实现的!关于具体操作可以参看相关的博客。

进程资源限制

每一个进程都有资源限制:

struct rlimit {

rlim_t rlim_cur; /* Soft limit */

rlim_t rlim_max; /* Hard limit (ceiling for rlim_cur) */

}; 这是常见的一些限制

- RLIMIT_AS

- 进程虚拟内存限制大小(字节数),即进程总的可用存储空间的最大长度

- yixie试图(brk()、sbrk()、mmap()、mremap()以及 shmat())超出这个限制会得到 ENOMEM 错误。

- 在实践中,程序中会超出这个限制的最常见的地方是在调用 malloc 包中的函数时,因为它们会使用 sbrk()和mmap()。当碰到这个限制时,栈增长操作也会失败,进而会出现下面 RLIMIT_STACK 限制中列出的情况。

- RLIMIT_CORE

- 核心文件大小(字节数),即core文件的最大字节数

- 当达到这个限制时,核心 dump 文件就不会再产生了

- 如果值为0标识阻止创建core文件

- 这种做法有时候是比较有用的,因为核心 dump 文件可能会变得非常大,而最终用户通常又不知道如何处理这些文件。

- 另一个禁用核心 dump文件的原因是安全性——防止程序占用的内存中的内容输出到磁盘上。

- 如果 RLIMIT_FSIZE限制值低于这个限制值,那么核心 dump 文件的最大大小会被限制为 RLIMIT_FSIZE 字节。

- RLIMIT_CPU

- 进程最多使用的 CPU 时间(包括系统模式和用户模式)。

- 当超过此软限制时,向该进程发送SIGXCPU信号(SIGXCPU 信号的默认动作是终止一个进程并输出一个核心 dump。此外,也可以捕获这个信号并将控制返回给主程序。)。

- 不同的 UNIX 实现对进程处理完 SIGXCPU 信号之后继续消耗 CPU 时间这种情况的处理方式不同。大多数会每隔固定时间间隔向进程发送一个 SIGXCPU 信号。

- 在达到软限制值之后,Linux 内核会在进程每消耗一秒钟的 CPU 时间后向其发送一个 SIGXCPU 信号。当进程持续执行直至达到硬 CPU 限制时,内核会向其发送一个 SIGKILL 信号,该信号总是会终止进程。

- RLIMIT_DATA

- 数据段的最大字节长度。这是初始化数据段、非初始化数据段、堆的总和

- 试图(sbrk()和 brk())访问这个限制之外的数据段会得到ENOMEM 的错误。

- 与 RLIMIT_AS 一样,程序中会超出这个限制的最常见的地方是在调用malloc 包中的函数时。

- RLIMIT_FSIZE

- 文件大小(字节数),即可以创建的文件的最大字节长度

- 当超过此软限制时,向该进程发送SIGXFSZ信号。并且系统调用(如 write()或truncate())会返回EFBIG错误。

- SIGXFSZ信号的默认动作是终止进程并产生一个核心dump。此外,也可以捕获这个信号并将控制返回给主程序。不管怎样,后续视图扩充该文件的操作都会得到同样的信号和错误。

- RLIMIT_MEMLOCK

- 一个进程最多能够将多少字节的虚拟内存锁进物理内存以防止内存被交换出去

- 这个限制会影响 mlock()和 mlockall()系统调用以及 mmap()和 shmctl()系统调用的加锁参数

- 如果在调用 mlockall()时指定了 MCL_FUTURE 标记,那么 RLIMIT_MEMLOCK 限制也会导致后续的 brk()、sbrk()、mmap()和 mremap()调用失败

- RLIMIT_MSGQUEUE

- 能够为调用进程的真实用户 ID 的 POSIX 消息队列分配的最大字节数。

- RLIMIT_MSGQUEUE 限制只会影响调用进程。这个用户下的其他进程不会受到影响,因为它们也会设置这个限制或继承这个限制。

- RLIMIT_NICE

- 规定了使用 sched_setscheduler()和 nice()能够为进程设置的最大 nice 值。

- 这个最大值是通过公式 20 – rlim_cur 计算得来的,其中 rlim_cur 是当前的 RLIMIT_NICE 软资源限制

- RLIMIT_NOFILE

- 一个进程能够分配的最大文件描述符数量加 1

- 试图(如 open()、pipe()、socket()、accept()、shm_open()、dup()、dup2()、fcntl(F_DUPFD)和 epoll_create())分配的文件描述符数量超出这个限制时会失败。

- 在大多数情况,失败的错误是 EMFILE

- 在 dup2(fd, newfd)调用中,失败的错误是 EBADF,

- 在 fcntl(fd, F_DUPFD, newfd)调用中当 newfd 大于或等于这个限制时,失败的错误是 EINVAL。

- 更改此限制将影响到sysconf函数在参数_SC_OPEN_MAX中返回的值

- 在 Linux 上可以通过使用 readdir()扫描/proc/PID/fd 目录下的内容来检查一个进程当前打开的文件描述符,这个目录包含了进程当前打开的每个文件描述符的符号链接。

- 从 2.6.25 的版本开始,这个限制由 Linux 特有的/proc/sys/fs/nr_open 文件定义。这个文件中的默认值是 1048576,超级用户可以修改这个值。试图将软或硬 RLIMIT_NOFILE 限制设置为一个大于最大值的值会产生 EPERM 错误。

- 还存在一个系统级别的限制,它规定了系统中所有进程能够打开的文件数量,通过 Linux 特有的/proc/sys/fs/file-max 文件能够获取和修改这个限制。

- 只有特权(CAP_SYS_ADMIN)进程才能够超出 file-max 的限制。

- 在非特权进程中,当系统调用碰到 file-max 限制时会返回 ENFILE 错误

- RLIMIT_NPROC

- 规定了调用进程的真实用户 ID 下最多能够创建的进程数量。

- 试图(fork()、vfork()和 clone())超出这个限制会得到 EAGAIN 错误

- RLIMIT_NPROC 限制只影响调用进程。这个用户下的其他进程不会受到影响,除非它们也设置或继承了这个限制。这个限制不适用于特权(CAP_SYS_ADMIN 和 CAP_SYS_RESOURCE)进程。

- Linux 还提供了系统层面的限制来规定所有用户能够创建的进程数量。在 Linux 2.4以及之后的版本中,可以使用 Linux 特有的/proc/sys/kernel/threads-max 文件来获取和修改这个限制

- 准确地说,RLIMIT_NPROC 资源限制和 threads-max 文件实际上限制的是所能创建的线程数量,而不是进程的数量

- 更改此限制将影响到sysconf函数在参数_SC_CHILD_MAX中返回的值

- 不存在一种统一的方法能够在不同系统中找出某个特定用户 ID 已经创建的进程数。

- RLIMIT_RSS

- 进程驻留集中的最大页面数,即当前位于物理内存中的虚拟内存页面总数。

- Linux 提供了这个限制,但当前并没有起任何作用

- 如果可用的物理存储器非常少,则内核将从进程处取同超过RSS的部分

- RLIMIT_RTPRIO

- 规定了使用 sched_ setscheduler()和 sched_setparam()能够为进程设置的最高实时优先级(自 Linux 2.6.12 起)

- RLIMIT_RTTIME

- 规定了一个进程在实时调度策略中不睡眠(即执行一个阻塞系统调用)的情况下最大能消耗的 CPU 秒数(微秒;自 Linux 2.6.25 起)

- 如果进程达到了软限制,那么内核会向进程发送一个 SIGXCPU 信号,之后进程每消耗一秒的 CPU 时间都会收到一个SIGXCPU 信号。在达到硬限制时,内核会向进程发送一个 SIGKILL 信号。

- RLIMIT_SBSIZE

- 在任一给定时刻,一个用户可以占用的套接字缓冲区的最大长度(字节)

- RLIMIT_SIGPENDING

- 一个进程可排队的信号最大数量制(Linux 特有的,自 Linux 2.6.8 起)

- 试图(sigqueue())超出这个限制会得到 EAGAIN错误。

- RLIMIT_SIGPENDING 只影响调用进程。这个用户下的其他进程不会受到影响,除非它们也设置或继承了这个限制 - RLIMIT_STACK

- 栈段的大小(字节数)

- 试图扩展栈大小以至于超出这个限制会导致内核向该进程发送一个 SIGSEGV 信号。

- 由于栈空间已经被用光了,因此捕获这个信号的唯一方式是建立另外一个备用的信号栈,

- RLIMIT_VMEN

- 这时RLIMIT_AS的同义词

进程切换

为了控制进程的执行,内核必须有能力挂起正在CPU上运行的进程!以恢复以前挂起的某个进程的执行。这种行为被称为进程切换,任务切换或者是上下文切换。

硬件上下文

尽管每个进程都可以拥有自己的地址空间,但所有的进程必须共享CPU的寄存器!因此在恢复一个进程的执行以前内核必须确保每个寄存器装入了挂起进程时的值。进程恢复至执行前必须装入寄存器的一组数据被称为硬件上下文

硬件上下文是进程可执行上下文的一个子集,因为可执行上下文包含进程执行时需要的所有信息。Linux 2.6使用软件执行线程切换:通过一组move指令逐步执行切换,这样能较好地控制所装入数据的合法性。尤其是这时检查ds和es段寄存器的值成为可能

任务状态段TSS用来存放硬件上下文,尽管Linux并不使用硬件上下文切换,但它强制为每个系统中每个不同的CPU创建一个TSS。这么做的理由有:当8086的一个CPU从用户态切换到内核态时它就从TSS中获取内核态堆栈的地址,当用户态进程试图通过IN或OUT指令访问一个io端口时,CPU需要访问存放在TSS中的io许可全位图,以检查该进程是否有访问端口的能力!

执行进程切换进程切换只能发生在精心定义的点:schedule函数。这里我们仅关心内核如何执行一个进程切换//从本质上来说每个进程切换有两步组成:

切换页全局目录已安装一个新的地址空间。

切换内核态堆栈和硬件上下文

因为硬件上下文提供了内核执行新进程所需要的所有信息,包括CPU的寄存器!

switch_to宏

进程切换的第二步由switch_to宏执行。它是内核中与硬件关系最密切的历程之一。首先该宏有三个参数它们是prev,next和last。在任何进程切换中涉及到三个进程而不是两个。因为假设内核正决定战役进程A而激活B,在schedule函数中Prev指向a的描述符而next指向B的描述符。一旦是a暂停,a的执行流就被冻结了。随后当内核再次想激活a时,又必须暂停另一个进程C!这通常不同于B(你想想B可能也被切换走了)于是就要用prev指向C,而next选项a来执行另一个switch to宏。当a恢复它的执行流时就会找到他原来的内核栈。于是prev局部变量还是指向a的描述符。next指向B的描述符。此时代表a的执行的内核就失去了对C的任何作用,但是事实表明这个引用对于完成进程切换还是很有用!

switch_to宏最后一个参数表示输出参数,它表示宏把进程C的描述地址写在了什么位置

下面来简述简述汇编语言是如何实现进程切换的:

- 在EAX和EDX寄存器中分别保存prev和next的值

movl prev, %eax

movl next, %edx把eflags和ebp寄存器的内容保存在prev内核栈中,必须保存他们的原因是编译器认为在switch to结束之前他们的值是保持不变的!

pushfl

pushl %ebp 把ESP的内容保存到prev指向的thread.esp中,使该字段指向prev内核栈的栈顶

movl %esp, 484(%eax) 把next指向thread.esp装入ESP,此时内核开始在next的内核栈上操作!因此这条指令实际上完成了从prev项next的切换

mov 484(%edx), %esp 把标记为一的地址存入prev->thread.eip。当被替换的进程重新执行时,进程执行被标记为一的那条指令。

movl $1f, 480(%eax) 宏把next thread.eip的值压入next的内核栈:

pushl 480(%edx) 跳到__switch_to()C函数,(这里就是主要完成硬件上下文切换,更新TSS,我们不讲)

jmp __switch_to 这里被进程B替换的进程A再次获得CPU。它执行一些保存eflags和ebp寄存器内容的指令,这里两条指令的第一条被标记为1

1:

popl %ebp

popfl 注意这些pop指令是如何引用prev进程的内核栈的!当进程调度程序选择prev作为进程,在CPU上运行时将执行这些指令!

拷贝寄存器的内容到switch_to宏的第三个参数last标识的内存区域中:

movl %eax, last创建进程

Unix操作系统仅仅依赖进程创建来满足用户的需求现代Unix内核引入了三种不同的机制来加快进程创建和减轻进程创建的开销写时复制技术允许父子进程读取相同的物理也只有两者中的有一个试图写一个物理页内核就把这个页拷贝到一个新的物理页并且把新的物理页分配给正在写的进程轻量级进程允许父子之间共享每进程之间的内河的很多数据结构比如说列表打开文件表和信号处理微fork系统调用创建的进程能共享其父进程的内存地址空间为了防止父进程重写子进程需要的数据需要阻塞父进程的执行一直到子进程退出或执行一个新的程序为止但是这个调用基本上不被提倡

在Linux在中,我们使用clone来创建轻量级的进程,这是一些常见的标志

CLONE_NEWNS:使新进程拥有一个新的、独立的挂载命名空间,可以隔离文件系统。

CLONE_NEWUTS:使新进程拥有一个新的、独立的 UTS 命名空间,可以隔离主机名和域名。

CLONE_NEWIPC:使新进程拥有一个新的、独立的 IPC 命名空间,可以隔离 System V IPC 和 POSIX 消息队列。

CLONE_NEWNET:使新进程拥有一个新的、独立的网络命名空间,可以隔离网络设备、协议栈和端口。

CLONE_NEWPID:使新进程拥有一个新的、独立的 PID 命名空间,可以隔离进程 ID。

CLONE_NEWUSER:使新进程拥有一个新的、独立的用户命名空间,可以隔离用户和组 ID。

CLONE_FILES:使新进程共享打开的文件描述符表,但不共享文件描述符的状态(例如文件偏移量)。

CLONE_FS:使新进程共享文件系统信息(例如当前工作目录和根目录)。

CLONE_VM:使新进程共享虚拟内存空间,即在进程之间共享代码和数据段。

CLONE_SIGHAND:使新进程共享信号处理程序。

CLONE_THREAD:使新进程成为调用进程的线程,与父进程共享进程 ID 和资源,但拥有独立的栈。do_fork

clone, fork, vfork底层:

它执行以下这些步骤

- 通过查找pidmap_array位图,为子进程分配新的PID

- 检查父进程的ptrace字段(current->ptrace):如果它的值不等于0,说明有另外一个进程正在跟踪父进程,因而,do_fork()检查debugger程序是否自己想跟踪子进程(独立于由父进程指定的CLONE_PTRACE标志的值)。在这种情况下,如果子进程不是内核线程(CLONE_UNTRACED标志被清0),那么do_fork()函数设置CLONE_PTRACE标志。

- 调用copy_process()复制进程描述符。如果所有必须的资源都是可用的,该函数返回刚创建的task_struct描述符的地址。这是创建过程的关键步骤,将在do_fork()之后描述它。

- 如果设置了CLONE_STOPPED标志,或者必须跟踪子进程,即在p->ptrace中设置了PT_PTRACED标志,那么子进程的状态被设置成TASK_STOPPED,并为子进程增加挂起的SIGSTOP信号。在另外一个进程(不妨假设是跟踪进程或是父进程)把子进程的状态恢复为TASK_RUNNING之前(通常是通过发送SIGCONT信号),子进程将一直保持TASK_STOPPED状态。

- 如果没有设置CLONE_STOPPED标志,则调用wake_up_new_task()函数以执行下述操作:

a.调整父进程和子进程的调度参数

b.如果子进程将和父进程运行在同一个CPU上(当内核创建一个新进程时父进程有可能会被转移到另一个CPU上执行),而且父进程和子进程不能共享同一组页表(CLONE_VM标志被清0),那么,就把子进程插入父进程运行队列,插入时让子进程恰好在父进程前面,因此而迫使子进程先于父进程运行。如果子进程刷新其地址空间,并在创建之后执行新程序,那么这种简单的处理会产生较好的性能。而如果我们让父进程先运行,那么写时复制机制将会执行一系列不必要的页面复制。

c.否则,如果子进程与父进程运行在不同的CPU上,或者父进程和子进程共享同一组页表(CLONE_VM标志被置位),就把子进程插入父进程运行队列的队尾。

- 如果CLONE_STOPPED标志被置位,则把子进程置为TASK_STOPPED状态。

- 如果父进程被跟踪,则把子进程的PID存入current的ptrace_message字段并调用ptrace_notify()。ptrace_notify()是当前进程停止运行,并向当前进程的父进程发送SIGCHLD信号。子进程的祖父进程是跟踪父进程的debugger进程。SIGCHLD信号通知debugger进程:current已经创建了一个子进程,可以通过查找current->ptrace_message字段获得子进程的PID。

- 如果设置了CLONE_VFORK标志,则把父进程插入等待队列,并挂起父进程直到子进程释放自己的内存地址空间(也就是说,直到子进程结束或执行新的程序)。

- 结束并返回子进程的PID。

欸,来看看中间的copy_process

- 定义返回值亦是

retval和新的进程描述符task_struct结构p。 - 标志合法性检查。对clone_flags所传递的标志组合进行合法性检查。当出现以下三种情况时,返回出错代号:

- CLONE_NEWNS和CLONE_FS同时被设置。前者标志表示子进程需要自己的命名空间,而后者标志则代表子进程共享父进程的根目录和当前工作目录,两者不可兼容。在传统的Unix系统中,整个系统只有一个已经安装的文件系统树。每个进程从系统的根文件系统开始,通过合法的路径可以访问任何文件。在2.6版本中的内核中,每个进程都可以拥有属于自己的已安装文件系统树,也被称为命名空间。通常大多数进程都共享init进程所使用的已安装文件系统树,只有在clone_flags中设置了CLONE_NEWNS标志时,才会为此新进程开辟一个新的命名空间。

- CLONE_THREAD被设置,但CLONE_SIGHAND未被设置。如果子进程和父进程属于同一个线程组(CLONE_THREAD被设置),那么子进程必须共享父进程的信号(CLONE_SIGHAND被设置)。

- CLONE_SIGHAND被设置,但CLONE_VM未被设置。如果子进程共享父进程的信号,那么必须同时共享父进程的内存描述符和所有的页表(CLONE_VM被设置)。

安全性检查。通过调用security_task_create()和后面的security_task_alloc()执行所有附加的安全性检查。询问 Linux Security Module (LSM) 看当前任务是否可以创建一个新任务。LSM是SELinux的核心。

复制进程描述符。通过dup_task_struct()为子进程分配一个内核栈、thread_info结构和task_struct结构。注意,这里将当前进程描述符指针作为参数传递到此函数中。首先,该函数分别定义了指向task_struct和thread_info结构体的指针。接着,prepare_to_copy为正式的分配进程描述符做一些准备工作。主要是将一些必要的寄存器的值保存到父进程的thread_info结构中。这些值会在稍后被复制到子进程的thread_info结构中。执行alloc_task_struct宏,该宏负责为子进程的进程描述符分配空间,将该片内存的首地址赋值给tsk,随后检查这片内存是否分配正确。执行alloc_thread_info宏,为子进程获取一块空闲的内存区,用来存放子进程的内核栈和thread_info结构,并将此会内存区的首地址赋值给ti变量,随后检查是否分配正确。

- 上面已经说明过orig是传进来的current宏,指向当前进程描述符的指针。arch_dup_task_struct直接将orig指向的当前进程描述符内容复制到当前里程描述符tsk。接着,用atomic_set将子进程描述符的使用计数器设置为2,表示该进程描述符正在被使用并且处于活动状态。最后返回指向刚刚创建的子进程描述符内存区的指针。

- 通过dup_task_struct可以看到,当这个函数成功操作之后,子进程和父进程的描述符中的内容是完全相同的。在稍后的copy_process代码中,我们将会看到子进程逐步与父进程区分开来。

- 一些初始化。通过诸如ftrace_graph_init_task,rt_mutex_init_task完成某些数据结构的初始化。调用copy_creds()复制证书(应该是复制权限及身份信息)。

- 检测系统中进程的总数量是否超过了max_threads所规定的进程最大数。

- 复制标志。通过copy_flags,将从do_fork()传递来的的clone_flags和pid分别赋值给子进程描述符中的对应字段。

- 初始化子进程描述符。初始化其中的各个字段,使得子进程和父进程逐渐区别出来。这部分工作包含初始化子进程中的children和sibling等队列头、初始化自旋锁和信号处理、初始化进程统计信息、初始化POSIX时钟、初始化调度相关的统计信息、初始化审计信息。它在copy_process函数中占据了相当长的一段的代码,不过考虑到task_struct结构本身的复杂性,也就不足为奇了。

- 调度器设置。调用sched_fork函数执行调度器相关的设置,为这个新进程分配CPU,使得子进程的进程状态为TASK_RUNNING。并禁止内核抢占。并且,为了不对其他进程的调度产生影响,此时子进程共享父进程的时间片。

- 复制进程的所有信息。根据clone_flags的具体取值来为子进程拷贝或共享父进程的某些数据结构。比如copy_semundo()、复制开放文件描述符(copy_files)、复制符号信息(copy_sighand 和 copy_signal)、复制进程内存(copy_mm)以及最终复制线程(copy_thread)。

- 复制线程。通过copy_threads()函数更新子进程的内核栈和寄存器中的值。在之前的dup_task_struct()中只是为子进程创建一个内核栈,至此才是真正的赋予它有意义的值。

- 当父进程发出clone系统调用时,内核会将那个时候CPU中寄存器的值保存在父进程的内核栈中。这里就是使用父进程内核栈中的值来更新子进程寄存器中的值。特别的,内核将子进程eax寄存器中的值强制赋值为0,这也就是为什么使用fork()时子进程返回值是0。而在do_fork函数中则返回的是子进程的pid,这一点在上述内容中我们已经有所分析。另外,子进程的对应的thread_info结构中的esp字段会被初始化为子进程内核栈的基址。

- 分配pid。用alloc_pid函数为这个新进程分配一个pid,Linux系统内的pid是循环使用的,采用位图方式来管理。简单的说,就是用每一位(bit)来标示该位所对应的pid是否被使用。分配完毕后,判断pid是否分配成功。成功则赋给p->pid。

- 更新属性和进程数量。根据clone_flags的值继续更新子进程的某些属性。将 nr_threads加一,表明新进程已经被加入到进程集合中。将total_forks加一,以记录被创建进程数量。

- 如果上述过程中某一步出现了错误,则通过goto语句跳到相应的错误代码处;如果成功执行完毕,则返回子进程的描述符p。

内核进程

所有进程的祖先是0进程,他在初始化阶段从无到有的创建一个进程。进程1是init进程!

撤销有一个进程

进程的终止有两个:exitt_group来终结一个进程组,exit系统调用终结摸一个线程

do_group_exit

这个函数用来杀死属于current进程组的所有进程!它接收进程终止代号作为参数

- 首先它检查退出进程的signal_group_exit标志是否不为零,如果不为零,说明内核已经开始为进程组执行退出的过程!在这种情况下就把存放在

current->signal->group->exit_code中的值当做退出码,然后跳到第四步 - 否则设置进程的signal group exit标志并把中指戴好存放在

current->signal->group->exit_code字段调用 - zap_other_threads函数杀死杀死current进程组的其他进程

- 调用do_exit函数,把进程的终止代号传递给他

do_exit函数

做这些事情:

- 把进程描述符的flag字段设置为PF_EXITING标志,以表示进程正在被删除。

- 如果需要,通过函数del_timer_sync()从动态定时器队列中删除进程描述符。

- 分别调用exit_mm()、exit_sem()、__exit_files()、__exit_fs()、exit_namespace()和exit_thread()函数从进程描述符中分离出与分页、信号量、文件系统、打开文件描述符、命名空间以及I/O权限位图相关的数据结构。如果没有其它进程共享这些数据结构,那么这些函数还删除所有这些数据结构中。

- 如果实现了被杀死进程的执行域和可执行格式的内核函数包含在内核模块中,则函数递减它们的使用计数器。

- 把进程描述符的exit_code字段设置成进程的终止代号,这个值要么是_exit()或exit_group()系统调用参数,要么是由内核提供的一个错误代码。

调用exit_notify()函数执行下面的操作:

- 更新父进程和子进程的亲属关系。如果同一线程组中有正在运行的进程,就让终止进程所创建的所有子进程都变成同一线程组中另外一个进程的子进程,否则让它们成为init的子进程

- 检查被终止进程其进程描述符的exit_signal字段是否不等于-1,并检查进程是否是其所属进程组的最后一个成员。在这种情况下,函数通过给正被终止进程的父进程发送一个信号,以通知父进程子进程死亡。

- 否则,也就是exit_signal字段等于-1,或者线程组中还有其它进程,那么只要进程正在被跟踪,就向父进程发送一个SIGCHLD信号。

- 如果进程描述符的exit_signal字段等于-1,而且进程没有被跟踪,就把进程描述符的exit_state字段置为EXIT_DEAD,然后调用release_task()回收进程的其它数据结构占用的内存,并递减进程描述符的使用计数器,以使进程描述符本身正好不会被释放。

- 否则,如果进程描述符的exit_signal字段不等于-1,或进程正在被跟踪,就把exit_state字段置为EXIT_ZOMBIE。

- 把进程描述符的flags字段设置为PF_DEAD标志。

调用schedule()函数选择一个新进程运行。调度程序忽略处于EXIT_ZOMBIE状态的进程,所以这种进程正好在schedule()中的宏switch_to被调用之后停止执行。

Reference

中断与异常

中断通常被定义为一个事件:让事件改变处理器执行的指令顺序这样的事件,与CPU芯片内外部硬件电路产生的电信号相对应!

中断通常分为同步中断与异步中断:

同步中断指的是当指令执行时,由CPU控制单元产生的。之所以称为同步,是因为只有在一条指令终止执行后,CPU才会发出中断!

异步中断是由其他硬件设备依照CPU时钟信号随机产生的

在英特尔微处理器手册中:也会把同步和异步中断分别称为异常和中断

中断则是由间隔定时器或者io设备产生的,举个例子你敲击键盘的时候,你的一次按键就会引发一个中断,希望操作系统介入进行处理!

另一方面异常是由程序的错误产生的,或者是由内核必须处理的异常条件产生的!比如说内核通过发送一个信号来处理异常,或者内核执行恢复异常所需要的步骤,比如说缺页,比如说对内核服务的一个请求

中断信号的作用

顾名思义,中断信号提供了一种特殊的方式来让处理器转而去运行正常控制流之外的代码。当一个中断信号到达的时候CPU必须停止它当前所做的事情,转而切换去处理这些终端。为了做到这一点就需要把内核态堆栈保存PC当前的值,并且把中断相关类型的的一个地址放进程序计数器中。这样才会跳转去执行处理中断的代码。

中断处理器内核执行的最敏感的任务之一,因为它必须要满足:

- 让内核正打算去完成别的事情的,由于中断随时都会到来,因此内核的目标就是:让中断尽可能的处理完尽可能把更多的更详细的处理向后推,所以中断响应分为两个部分:

- 关键而紧急的部分这一部分,内核立即执行。

- 其推迟的部分,则是内核随后执行。

- 因为中断随时会到来,所以内核可能正在处理其中一个中断的时候,另一个中断又发生了。应该尽可能地允许这种情况发生,因为这将会保持更多的io设备处于忙状态。因此中断处理程序必须编写成可以使相应的内核控制路径以嵌套的方式进行,执行到最后一个内核控制路径终止时,内核可以恢复被中断进程的执行,或者如果中断信号已导致了重新调度,内核可以切换到另外的进程。

- 尽管内核在处理前一个中断的时候,可以接受新的中断,但在内核代码区中仍然存在着一些临界区,在这些临界区中中断必须被禁止

中断和异常

英特尔文档把中断和异常又分为了以下几类:

- 中断:

又分出两类即:

| 类型 | 说明 |

|---|---|

| 可屏蔽中断 | IO设备发出的所有中断请求(Interruppt Request)都产生可屏蔽的中断,它处于两状态:屏蔽的和非屏蔽的,如果一个中断是被屏蔽的,那么控制单元会被它会忽略它 |

| 非可屏蔽中断 | 只有少数的几个危机事件是这样的,非屏蔽的中断总是由CPU辨认 |

异常:

异常分两类,处理器探测异常和编程异常。

处理器探测异常有三种

| 类型 | 说明 |

|---|---|

| 故障 | 通常可以被纠正,一旦纠正,程序就可以在不失连贯性的情况下,重新开始!保存在EIP中的值就是引起故障的指令地址,因此当异常处理程序终止时,那条指令会被重新执行 |

| 陷阱 | 在陷阱执行后,立即报告内核把控制权返回给程序后,就可以继续它的执行而不失去连贯性。保存在EIP中的值是一个随后要执行的指令地址,只有当没有必要重新执行已中止的指令时,才会触发陷阱。陷阱的主要目的是为了调试程序 |

| 异常终止 | 异常终止指的是发生了一个严重的错误及控制单元出现了问题,不能在EIP寄存器中保存引发了这个异常指令所在的确切位置。异常终止用的报告严重的错误,如硬件故障或系统表中无效的值或不一样的值。 |

编程异常:在编程者发出请求时发生是由int或int3指令触发的当into(检查溢出)和bound(检查地址出界)指令检查的条件不为真时,会引发编程异常控制单元!编程异常当作陷阱来处理,编程异常也被称为软中断,这样的异常常有两种的用途执行:系统调用以及给调试程序通报一个特定的事件。

IRQ与中断

每个能够发出中断请求的硬件设备系都有一条名为IRQ的输出线,所有现有的IRQ线都与一个名为可编程中断控制器的硬件电路的输入引脚相连,可编程中断控制器执行下列动作:

- 监视IRQ线检查产生的信号,如果有两条或两条以上的IRQ线上产生信号,选择引脚编号较小的IRQ线

- 如果一个引发信号出现在线上,那么它会把接收到的信发信号转换成对应的向量,把这个向量存放在中断控制器的一个io端口,从而允许CPU通过数据总线读取此向量。把引发信号发送到处理器的INTR引脚,也就是产生了一个中断

- 等待直到CPU通过把这个中断信号写进可编程中断控制器的io端口号,来确认它,当这种情况发生时,清理INTR线。然后继续监视。

异常

这里给出一些常见的异常:

| 异 常 一 览 表 | 向量号 | 异常名称 | 异常类型 | 出错代码 | 相关指令 |

|---|---|---|---|---|---|

| 0 | 除法出错 | 故障 | 无 | DIV,IDIV | |

| 1 | 调试异常 | 故障/陷阱 | 无 | 任何指令 | |

| 3 | 单字节INT3 | 陷阱 | 无 | INT 3 | |

| 4 | 溢出 | 陷阱 | 无 | INTO | |

| 5 | 边界检查 | 故障 | 无 | BOUNT | |

| 6 | 非法操作码 | 故障 | 无 | 非法指令编码或操作数 | |

| 7 | 设备不可用 | 故障 | 无 | 浮点指令或WAIT | |

| 8 | 双重故障 | 中止 | 有 | 任何指令 | |

| 9 | 协处理器段越界 | 中止 | 无 | 访问存储器的浮点指令 | |

| 0AH | 无效TSS异常 | 故障 | 有 | JMP、CALL、IRET或中断 | |

| 0BH | 段不存在 | 故障 | 有 | 装载段寄存器的指令 | |

| 0CH | 堆栈段异常 | 故障 | 有 | 装载SS寄存器的任何指令、对SS寻址的段访问的任何指令 | |

| 0DH | 通用保护异常 | 故障 | 有 | 任何特权指令、任何访问存储器的指令 | |

| 0EH | 页异常 | 故障 | 有 | 任何访问存储器的指令 | |

| 10H | 协处理器出错 | 故障 | 无 | 浮点指令或WAIT | |

| 11H—0FFH | 软中断 | 陷阱 | 无 | INT n |

中断向量表

中断描述符表IDT是一个系统表,它与每一个中断或者异常向量相联系

每一个向量在表中都有相应的中断或异常处理程序的入口地址,内核在允许中断发生前,必须适当初始化IDT

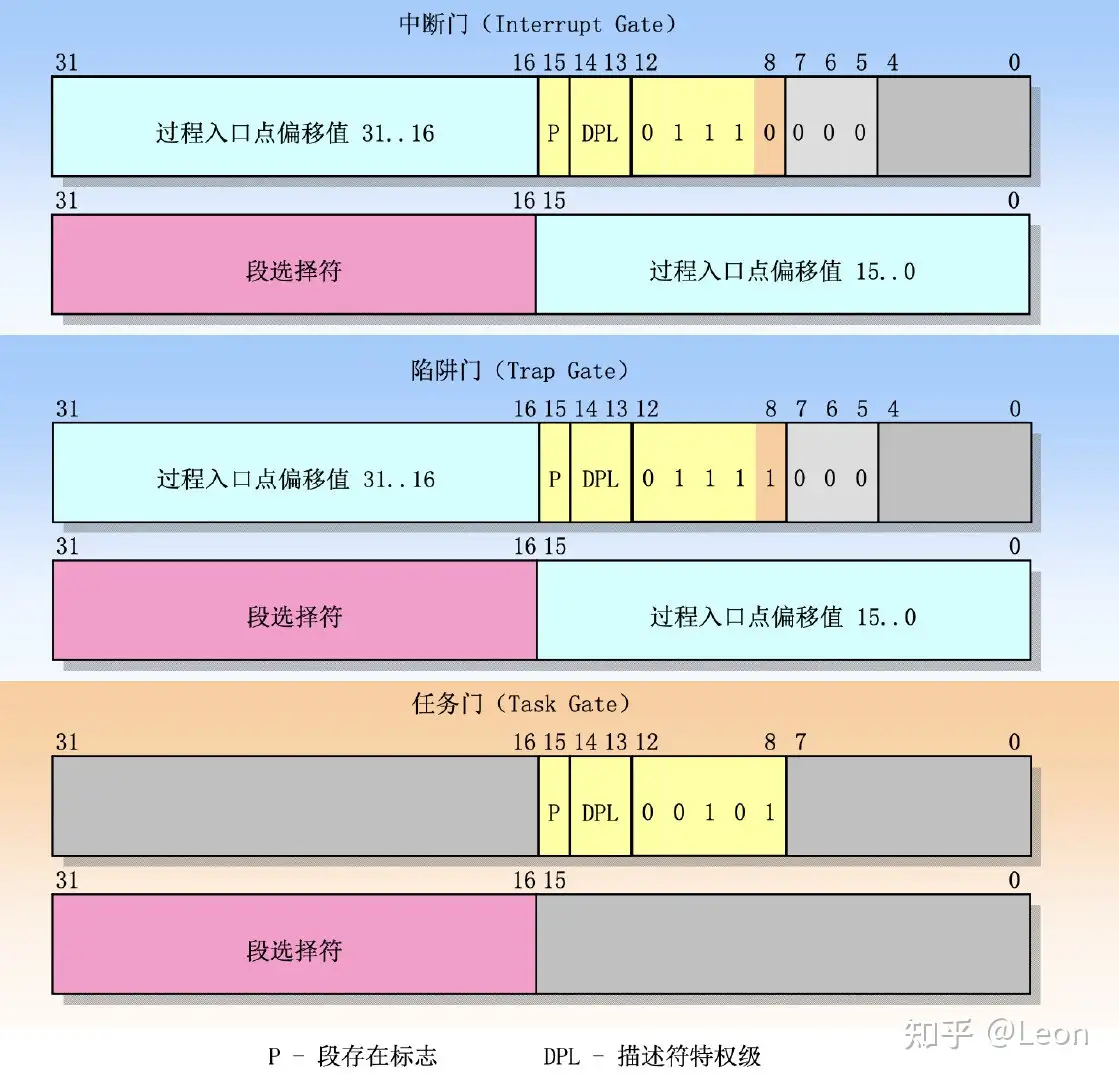

下图为IDT的结构表示图:

这些描述符是:

- 任务门

Task Gate:当中断信号发生时,必须取代当前进程的那个进程的TSS选择符,存放在任务门中 - 中断门

Interrupt Gate:包含段选择符和中断或异常处理程序的段内偏移量,当控制权转移到应适当的段时,处理器清IF标志,从而关闭即将会发生的可屏蔽中断。 - 陷阱门

Trap Gate:与中断门相似只是控制权传递到一个适当的段时处理器不修改IF标志Linux使用中断门处理中断应用陷阱门处理异常

硬件处理

现在描述CPU控制单元是如何处理中断和异常的!

我们现在假定内核已经被初始化,因此CPU将会在保护模式下运行。

当执行了一条指令后,CS和EIP这对寄存器将会包含下一条将要执行的指令的逻辑地址。在处理那条指令之前控制单元会检查在运行前一条指令是否已经发生一个中断或者异常,如果发生了,那么它将会:

确定与中断或异常关联的向量(看一眼是哪个异常)

读由寄存器指向的

IDT表中的i项(肘!IDT表爆破)从

gdpr寄存器中获取GDP的基地址,并在GDP中查找,以读取IDT表项的选择符所标识的段描述符。这个描述符指定中断或异常处理程序所在段的基地址(看看这个程序在哪里)确信中断事由授权的中断发生源发出的,首先将当前特权级CPL与段描述符的描述符特权级DPL的相比较:如果CPL小于DPL了就会产生一个

general protection异常,因为中断处理程序的特权不能低于引起中断的程序的特权!对于编程异常则需要做进一步的安全检查:比较CPL了与处于IDT中的门描述符的DPL了,如果DPL小于CPL了那么就产生一个general protection,这最后一个检查可以避免用户应用程序访问特殊的陷阱门和中断门(配不配处理这个异常)检查是否发生了特权级变化:也就是说CPL是否不同于所选择的段描述符的DPL,如果是,控制单元必须开始使用与新的特权级相关的栈,通过执行以下步骤来做到这一点:

- 读TR寄存器以访问运行进程的TSS段

- 用于新特权级相关的栈段和栈指针的正确值装载SS和ESP寄存器这些值,可以在TSS中找到在新的段中

- 保存SS和ESP以前的值,这些值定义了与旧特训级相关的栈的逻辑地址。

如果故障已经发生,用引起异常的指令地址装载CS和EIP寄存器,从而使得这条指令能够再次被执行!

在栈中保存eflags,cs,EIP等内容,如果引用异常产生了一个硬件出错码,把它保存到栈中,装在CS和EIP寄存器其值分别为IDT表中第I项门描述服务的段选择符和偏移量字段,这些值给出了中断或者异常处理的第一条指令的逻辑地址!

控制单元所执行的最后一步就是跳转到这些异常处理程序,换句话说处理完中断信号后控制单元所执行的指令,就是被选中处理程序的第一条指令!

当中断或处理结束后和异常被处理结束后相应的处理程序必须参与生一条iret指令,他把控制权转交给被中断的进程。这将会迫使控制单元:

- 用保存在栈中的值装在CS或eflags寄存器,如果一个硬件出错码曾经被压入栈中,并且在EIP内容的上面,那么执行Iret指令前必须弹出这个硬件错误码(准备回家)

- 检查处理程序的CPL是否等于CS中的最低两位的值如果是iret终止执行,否则执行下一步。(看看特权级够不够)

- 从栈中装载SS和ESP寄存器因此返回到与特权级相关的栈(也就是恢复栈)

- 检查DS ES FS 以及 GS段寄存器的内容,如果其中一个寄存器包含选择符是一个段描述符,并且其的DPL值小于CPL了,那么我们会清理相应的段寄存器控制单元,这么做是为了防止用户态的程序利用内核以前所用的段寄存器,如果不清理这些寄存器,那么一些怀有恶意的用户态程序就有可能利用他们来访问内核地址。(安全处理,安全恢复环境)

中断和异常处理程序的嵌套执行

每个中断或异常都会引起一个内核控制路径,或者说当前的进程在内核态执行单独的指令序列。

内核控制路径可以任意嵌套!一个中断处理程序可以被另一个中断处理程序所中断,因此这样就引起了内核控制路径的嵌套执行。允许内核控制路径嵌套执行必须要付出相应的代价,也就是中断处理程序必须永不阻塞换,中断处理程序在运行期间是不能够发生进程切换。

基于以下两个主要原因,Linux交错执行内核控制路径:

- 为了提高可编程中断控制器和设备控制中器的吞吐量。假定设备控制器在一条线上产生了一条信号,pic把这个信号转换成一个外部中断,然后pic和控制设备器保持阻塞一直到pic从内核CPU处接收一条应答信息!由于内核控制路径的交错执行内核即使正在处理前一个中断也能够发送应答。

- 为了实现一种没有优先级的中断模型,每个C中断处理程序都可以被另一个中断处理程序所延缓,因此在硬件设备之间没必要预定义优先级,这简化了内核代码,也提高了内核的可移植性!

初始化IDT

Linux在基于Intel给出的三种门之外,还更加细分了他们:

中断门(interrupt gate):用户态的进程不能访问的一个lntel中断门(门的DPL字段为0)。所有的Linux中 断处理程序都通过中断门激活,并全部限制在内核态。

系统门(syslem gate):用户态的进程可以访问的一个Intel陷阱门(门的DPL字段为到.通过系统门来激 活三个Linux异常处理程序,它们的向量是4,5及128,因此,在用户态下.可以 发布into、 bound及int $Ox80三条汇编语言指令。

系统中断门(system interrupt gate):能够被用户态进程访问的Intel中断门(门的DPL字段为3). 与向量3相关的异常 处理程序是由系统中断门激活的,因此,在用户态可以使用汇编语言指令int3.

陷阱门(Irapgate):用户态的进程不能访问的一个Inte)陷阱门(f]的DPL字段为0). 大部分Linux异 常处理程序都通过陷阱门来激活.

任务门(task gate):不能被用户态进程访问的Intel任务门(门的DPL字段为0).Linux对”Doublefault” 异常的处理程序是由任务门激活的.

IDT会被初始化两次。第一次是在BIOS程序中,此时CPU还工作在实模式下。一旦Linux启动,IDT会被搬运到RAM的受保护区域并被第二次初始化,因为Linux不会使用任何BIOS程序。

IDT结构被存储在idt_table表中,包含256项。idt_descr变量存储IDT的大小和它的地址,在系统的初始化阶段,内核用来设置idtr寄存器,专用汇编指令是lidt。

内核初始化的时候,汇编函数setup_idt()用相同的中断门填充idt_table表的所有项,都指向ignore_int()中断处理函数:

setup_idt:

lea ignore_int, %edx

movl $(__KERNEL_CS << 16), %eax

movw %dx, %ax /* = 0x0010 = cs */

movw $0x8e00, %dx /* 中断门,DPL=0 */

lea idt_table, %edi /* 加载idt表的地址到寄存器edi中 */

mov $256, %ecx

rp_sidt:

movl %eax, (%edi) /* 设置中断处理函数 */

movl %edx, 4(%edi) /* 设置段描述符 */

addl $8, %edi /* 跳转到IDT表的下一项 */

dec %ecx /* 自减 */

jne rp_sidt

ret中断处理函数ignore_int(),也是一个汇编语言编写的函数,相当于一个null函数,它执行:

- 保存一些寄存器到堆栈中。

- 调用printk()函数打印

Unknown interrupt系统消息`。 - 从堆栈中恢复寄存器的内容。

- 执行iret指令回到调用处。

正常情况下,此时的中断处理函数ignore_int()是不应该被执行的。如果在console或者log日志中出现Unknown interrupt的消息,说明发生硬件错误或者内核错误。

完成这次IDT表的初始化之后,内核还会进行第二次初始化,用真正的trap或中断处理函数代替刚才的null函数。一旦这两步初始化都完成,IDT表就包含具体的中断、陷阱和系统门,用以控制每个中断请求。

中断处理

这里讨论三种中断类型:

IO中断,时钟中断。和处理器间中断io

中断处理程序必须足够灵活地给多个设备同时提供服务,比如说在PCI总线的体系架构中几个设备可以共享一个IRQ线,这也就意味着仅仅中断向量是并不能说明所有问题的!中断处理程序的灵活性是以两种不同的方式实现的:

IRQ共享

中断处理程序执行多个中断服务例程,每个中断服务例程是一个与单独设备相关的函数,因此不可能预先知道哪个特定的设备产生,因此每个IRQ,也就是中断服务例程,都会被执行验证它的设备是否需要关注,如果是,当设备产生中断时则需要执行相关的所有操作

IRQ动态分配

一条线可能在最后的时刻才会与一个设备驱动程序相关联,这样,即使几个硬件设备并不共享线,同一个向量也可以在这几个设备在不同时刻中使用。当一个中断发生时,并不是所有的操作都具有急迫性,,因此Linux会把紧随中断要执行的操作分为三类:

紧急的:这样的操作比如说对pic应答中断,对pic或设备控制器中编程重修改,由设备和处理器同时访问的数据结构这样的操作都可以很快的被执行,他们是紧急的,因为他们必须要尽快的执行紧急操作!要在一个中断处理程序内立即执行,而且是在禁止可屏蔽中断的情况下

非紧急的:这样的操作比如说修改那些只有处理器才会访问的数据结构,这样的操作必须也很快完成,因此它们由中断处理程序立即执行,但它们是在开中断的情况下执行的

非紧急可延迟的:比如说把缓冲区的内容拷贝到进程的地址空间中,这样的操作可能被延迟较长的时间间隔,而不会影响内核的操作!

不管引起中断的电路类型如何所有的io中断处理程序都执行四个基本的操作:

- 在内核态堆栈中保存的值与寄存器的内容

- 为正在给线服务的pic发送个应答,这将允许pic进一步发出中断

- 执行共享这个IRQ的所有设备都中断服务例程

- 跳到ret_from_intr的地址后终止

为一个IRQ可配置设备选择一条线,有三种方式:

- 设置一些硬件跳线跳接器

- 安装设备时执行一个实用程序,这样的程序可以让用户选择一个可用的RQ号或者探测系统自身以确定一个可用的IRQ号

- 在系统启动时执行一个硬件协议,外设宣布他们准备使用哪些中断线,然后协商一个最终的值以尽可能减少冲突,该过程一旦完成,每个中断处理程序都会通过访问设备的某个IO端口函数来读取所分配的IRQ

数据结构

对于每一个外设的IRQ都用 struct irq_desc 来描述,我们称之中断描述符(struct irq_desc)。linux kernel中会有一个数据结构保存了关于所有IRQ的中断描述符信息,我们称之中断描述符DB(上图中红色框图内)。当发生中断后,首先获取触发中断的HW interupt ID,然后通过irq domain翻译成IRQ number,然后通过IRQ number就可以获取对应的中断描述符

中断描述符

通用中断处理模块可以用一个线性的table来管理一个个的外部中断,这个表的每个元素就是一个irq描述符,在kernel中定义如下:

struct irq_desc irq_desc[NR_IRQS] __cacheline_aligned_in_smp = {

[0 ... NR_IRQS-1] = {

.handle_irq = handle_bad_irq,

.depth = 1,

.lock = __RAW_SPIN_LOCK_UNLOCKED(irq_desc->lock),

}

}; 系统中每一个连接外设的中断线(irq request line)用一个中断描述符来描述,每一个外设的 interrupt request line 分配一个中断号(irq number),系统中有多少个中断线(或者叫做中断源)就有多少个中断描述符(struct irq_desc)。NR_IRQS定义了该硬件平台IRQ的最大数目。

struct irq_desc {

struct irq_data irq_data;

unsigned int __percpu *kstat_irqs;------IRQ的统计信息

irq_flow_handler_t handle_irq;--------流控函数

struct irqaction *action; -----------处理函数

unsigned int status_use_accessors;-----中断描述符的状态,参考IRQ_xxxx

unsigned int core_internal_state__do_not_mess_with_it;

unsigned int depth;----------描述嵌套深度的信息

unsigned int wake_depth;--------电源管理中的wake up source相关

unsigned int irq_count;

unsigned long last_unhandled;

unsigned int irqs_unhandled;

raw_spinlock_t lock;

struct cpumask *percpu_enabled;

#ifdef CONFIG_SMP

const struct cpumask *affinity_hint;----和irq affinity相关,后续单独文档描述

struct irq_affinity_notify *affinity_notify;

#ifdef CONFIG_GENERIC_PENDING_IRQ

cpumask_var_t pending_mask;

#endif

#endif

unsigned long threads_oneshot;

atomic_t threads_active;

wait_queue_head_t wait_for_threads;

#ifdef CONFIG_PROC_FS

struct proc_dir_entry *dir;--------该IRQ对应的proc接口

#endif

int parent_irq;

struct module *owner;

const char *name;

} ____cacheline_internodealigned_in_smp响应函数 irqaction

在 irq_desc 中,struct irqaction action,主要是用来存用户注册的中断处理函数,一个中断可以有多个处理函数 ,当一个中断有多个处理函数,说明这个是共享中断。所谓*共享中断就是一个中断的来源有很多,这些来源共享同一个引脚。所以在irq_desc结构体中的action成员是个链表,以action为表头,若是一个以上的链表就是共享中断

struct irqaction {

irq_handler_t handler; //等于用户注册的中断处理函数,中断发生时就会运行这个中断处理函数

unsigned long flags; //中断标志,注册时设置,比如上升沿中断,下降沿中断等

cpumask_t mask; //中断掩码

const char *name; //中断名称,产生中断的硬件的名字

void *dev_id; //设备id

struct irqaction *next; //指向下一个成员

int irq; //中断号,

struct proc_dir_entry *dir; //指向IRQn相关的/proc/irq/

};中断数据 irq_data

中断描述符中应该会包括底层irq chip相关的数据结构,linux kernel中把这些数据组织在一起,形成struct irq_data,具体代码如下:

struct irq_data {

u32 mask;----------TODO

unsigned int irq;--------IRQ number

unsigned long hwirq;-------HW interrupt ID

unsigned int node;-------NUMA node index

unsigned int state_use_accessors;--------底层状态,参考IRQD_xxxx

struct irq_chip *chip;----------该中断描述符对应的irq chip数据结构

struct irq_domain *domain;--------该中断描述符对应的irq domain数据结构

void *handler_data;--------和外设specific handler相关的私有数据

void *chip_data;---------和中断控制器相关的私有数据

struct msi_desc *msi_desc;

cpumask_var_t affinity;-------和irq affinity相关

};操作合集 irq_chip

struct irq_chip {

const char *name;

unsigned int (*irq_startup)(struct irq_data *data);-------------初始化中断

void (*irq_shutdown)(struct irq_data *data);----------------结束中断

void (*irq_enable)(struct irq_data *data);------------------使能中断

void (*irq_disable)(struct irq_data *data);-----------------关闭中断

void (*irq_ack)(struct irq_data *data);---------------------应答中断

void (*irq_mask)(struct irq_data *data);--------------------屏蔽中断

void (*irq_mask_ack)(struct irq_data *data);----------------应答并屏蔽中断

void (*irq_unmask)(struct irq_data *data);------------------解除中断屏蔽

void (*irq_eoi)(struct irq_data *data);---------------------发送EOI信号,表示硬件中断处理已经完成。

int (*irq_set_affinity)(struct irq_data *data, const struct cpumask *dest, bool force);--------绑定中断到某个CPU

int (*irq_retrigger)(struct irq_data *data);----------------重新发送中断到CPU

int (*irq_set_type)(struct irq_data *data, unsigned int flow_type);----------------------------设置触发类型

int (*irq_set_wake)(struct irq_data *data, unsigned int on);-----------------------------------使能/关闭中断在电源管理中的唤醒功能。

void (*irq_bus_lock)(struct irq_data *data);

void (*irq_bus_sync_unlock)(struct irq_data *data);

void (*irq_cpu_online)(struct irq_data *data);

void (*irq_cpu_offline)(struct irq_data *data);

void (*irq_suspend)(struct irq_data *data);

void (*irq_resume)(struct irq_data *data);

void (*irq_pm_shutdown)(struct irq_data *data);

...

unsigned long flags;

}软中断,Tasklet和Work Queue

由内核执行的几个任务之间有一些不是紧急的,他们可以被延缓一段时间!把可延迟的中断从中断处理程序中抽出来,有利于使得内核保持较短的响应时间,所以我们现在使用以下面的这些结构,来把这样的非紧急的中断处理函数抽象出来!下面列出还在使用三个的机制:

软中断(softirq):内核2.3引入,是最基本、最优先的软中断处理形式,为了避免名字冲突,本文中将这种子类型的软中断叫softirq。

tasklet:其底层使用softirq机制实现,提供了一种用户方便使用的软中方式,为软中断提供了很好的扩展性。(封装了soft_irq)

work queue:前两种软中断执行时是禁止抢占的(softirq的ksoftirq除外),对于用户进程不友好。如果在softirq执行时间过长,会继续推后到work queue中执行,work queue执行处于进程上下文,其可被抢占,也可以被调度,如果软中断需要执行睡眠、阻塞,直接选择work queue。

软中断

前已注册的软中断有10种,定义为一个全局数组:

static struct softirq_action softirq_vec[NR_SOFTIRQS];

enum {

HI_SOFTIRQ = 0, /* 优先级高的tasklets */

TIMER_SOFTIRQ, /* 定时器的下半部 */

NET_TX_SOFTIRQ, /* 发送网络数据包 */

NET_RX_SOFTIRQ, /* 接收网络数据包 */

BLOCK_SOFTIRQ, /* BLOCK装置 */

BLOCK_IOPOLL_SOFTIRQ,

TASKLET_SOFTIRQ, /* 正常优先级的tasklets */

SCHED_SOFTIRQ, /* 调度程序 */

HRTIMER_SOFTIRQ, /* 高分辨率定时器 */

RCU_SOFTIRQ, /* RCU锁定 */

NR_SOFTIRQS /* 10 */

};(2)注册软中断处理函数

/**

* @nr: 软中断的索引号

* @action: 软中断的处理函数

*/

void open_softirq(int nr, void (*action) (struct softirq_action *))

{

softirq_vec[nr].action = action;

}例如:

open_softirq(NET_TX_SOFTIRQ, net_tx_action);

open_softirq(NET_RX_SOFTIRQ, net_rx_action);(3)触发软中断

调用raise_softirq()来触发软中断。

void raise_softirq(unsigned int nr)

{

unsigned long flags;

local_irq_save(flags);

raise_softirq_irqoff(nr);

local_irq_restore(flags);

}

/* This function must run with irqs disabled */

inline void rasie_softirq_irqsoff(unsigned int nr)

{

__raise_softirq_irqoff(nr);

/* If we're in an interrupt or softirq, we're done

* (this also catches softirq-disabled code). We will

* actually run the softirq once we return from the irq

* or softirq.

* Otherwise we wake up ksoftirqd to make sure we

* schedule the softirq soon.

*/

if (! in_interrupt()) /* 如果不处于硬中断或软中断 */

wakeup_softirqd(void); /* 唤醒ksoftirqd/n进程 */

}Percpu变量irq_cpustat_t中的__softirq_pending是等待处理的软中断的位图,通过设置此变量即可告诉内核该执行哪些软中断。

static inline void __rasie_softirq_irqoff(unsigned int nr)

{

trace_softirq_raise(nr);

or_softirq_pending(1UL << nr);

}

typedef struct {

unsigned int __softirq_pending;

unsigned int __nmi_count; /* arch dependent */

} irq_cpustat_t;

irq_cpustat_t irq_stat[];

#define __IRQ_STAT(cpu, member) (irq_stat[cpu].member)

#define or_softirq_pending(x) percpu_or(irq_stat.__softirq_pending, (x))

#define local_softirq_pending() percpu_read(irq_stat.__softirq_pending)唤醒ksoftirqd内核线程处理软中断。

static void wakeup_softirqd(void)

{

/* Interrupts are disabled: no need to stop preemption */

struct task_struct *tsk = __get_cpu_var(ksoftirqd);

if (tsk && tsk->state != TASK_RUNNING)

wake_up_process(tsk);

}在下列地方,待处理的软中断会被检查和执行:

a. 从一个硬件中断代码处返回时

b. 在ksoftirqd内核线程中

c. 在那些显示检查和执行待处理的软中断的代码中,如网络子系统中

而不管是用什么方法唤起,软中断都要在do_softirq()中执行。如果有待处理的软中断,do_softirq()会循环遍历每一个,调用它们的相应的处理程序。

在中断处理程序中触发软中断是最常见的形式。中断处理程序执行硬件设备的相关操作,然后触发相应的软中断,最后退出。内核在执行完中断处理程序以后,马上就会调用do_softirq(),于是软中断开始执行中断处理程序完成剩余的任务。

下面来看下do_softirq()的具体实现。

asmlinkage void do_softirq(void)

{

__u32 pending;

unsigned long flags;

/* 如果当前已处于硬中断或软中断中,直接返回 */

if (in_interrupt())

return;

local_irq_save(flags);

pending = local_softirq_pending();

if (pending) /* 如果有激活的软中断 */

__do_softirq(); /* 处理函数 */

local_irq_restore(flags);

}/* We restart softirq processing MAX_SOFTIRQ_RESTART times,

* and we fall back to softirqd after that.

* This number has been established via experimentation.

* The two things to balance is latency against fairness - we want

* to handle softirqs as soon as possible, but they should not be

* able to lock up the box.

*/

asmlinkage void __do_softirq(void)

{

struct softirq_action *h;

__u32 pending;

/* 本函数能重复触发执行的次数,防止占用过多的cpu时间 */

int max_restart = MAX_SOFTIRQ_RESTART;

int cpu;

pending = local_softirq_pending(); /* 激活的软中断位图 */

account_system_vtime(current);

/* 本地禁止当前的软中断 */

__local_bh_disable((unsigned long)__builtin_return_address(0), SOFTIRQ_OFFSET);

lockdep_softirq_enter(); /* current->softirq_context++ */

cpu = smp_processor_id(); /* 当前cpu编号 */

restart:

/* Reset the pending bitmask before enabling irqs */

set_softirq_pending(0); /* 重置位图 */

local_irq_enable();

h = softirq_vec;

do {

if (pending & 1) {

unsigned int vec_nr = h - softirq_vec; /* 软中断索引 */

int prev_count = preempt_count();

kstat_incr_softirqs_this_cpu(vec_nr);

trace_softirq_entry(vec_nr);

h->action(h); /* 调用软中断的处理函数 */

trace_softirq_exit(vec_nr);

if (unlikely(prev_count != preempt_count())) {

printk(KERN_ERR "huh, entered softirq %u %s %p" "with preempt_count %08x,"

"exited with %08x?\n", vec_nr, softirq_to_name[vec_nr], h->action, prev_count,

preempt_count());

}

rcu_bh_qs(cpu);

}

h++;

pending >>= 1;

} while(pending);

local_irq_disable();

pending = local_softirq_pending();

if (pending & --max_restart) /* 重复触发 */

goto restart;

/* 如果重复触发了10次了,接下来唤醒ksoftirqd/n内核线程来处理 */

if (pending)

wakeup_softirqd();

lockdep_softirq_exit();

account_system_vtime(current);

__local_bh_enable(SOFTIRQ_OFFSET);

}(4)ksoftirqd内核线程

内核不会立即处理重新触发的软中断。当大量软中断出现的时候,内核会唤醒一组内核线程来处理。这些线程的优先级最低(nice值为19),这能避免它们跟其它重要的任务抢夺资源。但它们最终肯定会被执行,所以这个折中的方案能够保证在软中断很多时用户程序不会因为得不到处理时间而处于饥饿状态,同时也保证过量的软中断最终会得到处理。

每个处理器都有一个这样的线程,名字为ksoftirqd/n,n为处理器的编号。

static int run_ksoftirqd(void *__bind_cpu)

{

set_current_state(TASK_INTERRUPTIBLE);

current->flags |= PF_KSOFTIRQD; /* I am ksoftirqd */

while(! kthread_should_stop()) {

preempt_disable();

if (! local_softirq_pending()) { /* 如果没有要处理的软中断 */

preempt_enable_no_resched();

schedule();

preempt_disable():

}

__set_current_state(TASK_RUNNING);

while(local_softirq_pending()) {

/* Preempt disable stops cpu going offline.

* If already offline, we'll be on wrong CPU: don't process.

*/

if (cpu_is_offline(long)__bind_cpu))/* 被要求释放cpu */

goto wait_to_die;

do_softirq(); /* 软中断的统一处理函数 */

preempt_enable_no_resched();

cond_resched();

preempt_disable();

rcu_note_context_switch((long)__bind_cpu);

}

preempt_enable();

set_current_state(TASK_INTERRUPTIBLE);

}

__set_current_state(TASK_RUNNING);

return 0;

wait_to_die:

preempt_enable();

/* Wait for kthread_stop */

set_current_state(TASK_INTERRUPTIBLE);

while(! kthread_should_stop()) {

schedule();

set_current_state(TASK_INTERRUPTIBLE);

}

__set_current_state(TASK_RUNNING);

return 0;

}Tasklet API

动态初始化函数:

void tasklet_init(struct tasklet_struct *t,void (*func)(unsigned long), unsigned long data)t: struct tasklet_struct结构指针func:小任务函数data:传递给工作函数的实际参数

静态初始化:静态初始化DECLARE_TASKLET(name, func, data),定义一个名字为 name 的结构变量 ,并且使用 func,data对结构进行初始化,这个宏定义的 tasklet 是可调度的。静态初始化DECLARE_TASKLET_DISABLED(name, func, data)和DECLARE_TASKLET(name, func, data),不同是它开始不能被调度。必须先把 count 设置为0,才可以调度

name:struct tasklet_struct的名字

func:tasklet函数指针

data:传递给func函数的参数激活/取消激活 tasklet

void tasklet_disable(struct tasklet_struct *t) // 把 count 设置为1

void tasklet_enable (struct tasklet_struct *t) // 把count 设置为0调度函数

void tasklet_schedule (struct tasklet_struct *t)调度某个指定的tasklet小任务,调用后tasklet关联的函数会执行.一旦执行,则会在适当时候去执行 tasklet_struct 绑定的函数。对同一个 struct tasklet_struct 连续调度多次,效果等同一次(前提条件:当前一次调用,绑定函数还没有执行)。

5)kill掉函数(取消任务)

tasklet_kill(struct tasklet_struct *t);6) tasklet和普通工作队列区别:

它所绑定的函数不能休眠

它的响应速度高于普通工作队列。

tasklet 微线程的编程步骤:

taskle 内核机制实现过程是非常复杂的,但是对于驱动开发者来说,重点是掌握如果使用内核已经给我们实现好的tasklet机制。tasklet编程其实只有简单的几步,下面我们总结一下tasklet机制的编程步骤。

1. 定义tasklet 工作函数

2. 定义tasklet 结构变量

定义分有静态定义和动态定义两种方式:

// 动态定义:

struct tasklet_struct my_tasklet;

// 静态定义:

DECLARE_TASKLET(my_tasklet, my_tasklet_function, data);3. 初始化tasklet结构,绑定工作函数

如果上一步是采用静态定义,则这一步不用再做,跳过。如果是采用动态定义tasklet,则使用tasklet_init()函数进行初始化以及绑定。

tasklet_init(&my_tasklet, my_tasklet_function, data)4. 在适当的地方调度工作函数

tasklet一般是用于处理中断的下半部的,所以一般在中断的上半部调度tasklet工作函数。

tasklet_schedule(&my_tasklet);5. 销毁tasklet工作任务

在确定不再使用tasklet时,应该在适当的地方调用tasklet_kill()函数销毁tasklet任务,释放资源,这个适当的地方一般的tasklet初始化地方是相反的,比如,如果是在模块初始化函数初始化了tasklet,则相应地是在模块卸载函数调用tasklet_kill函数来销毁tasklet任务。

tasklet_kill(&my_tasklet);从中断和异常返回

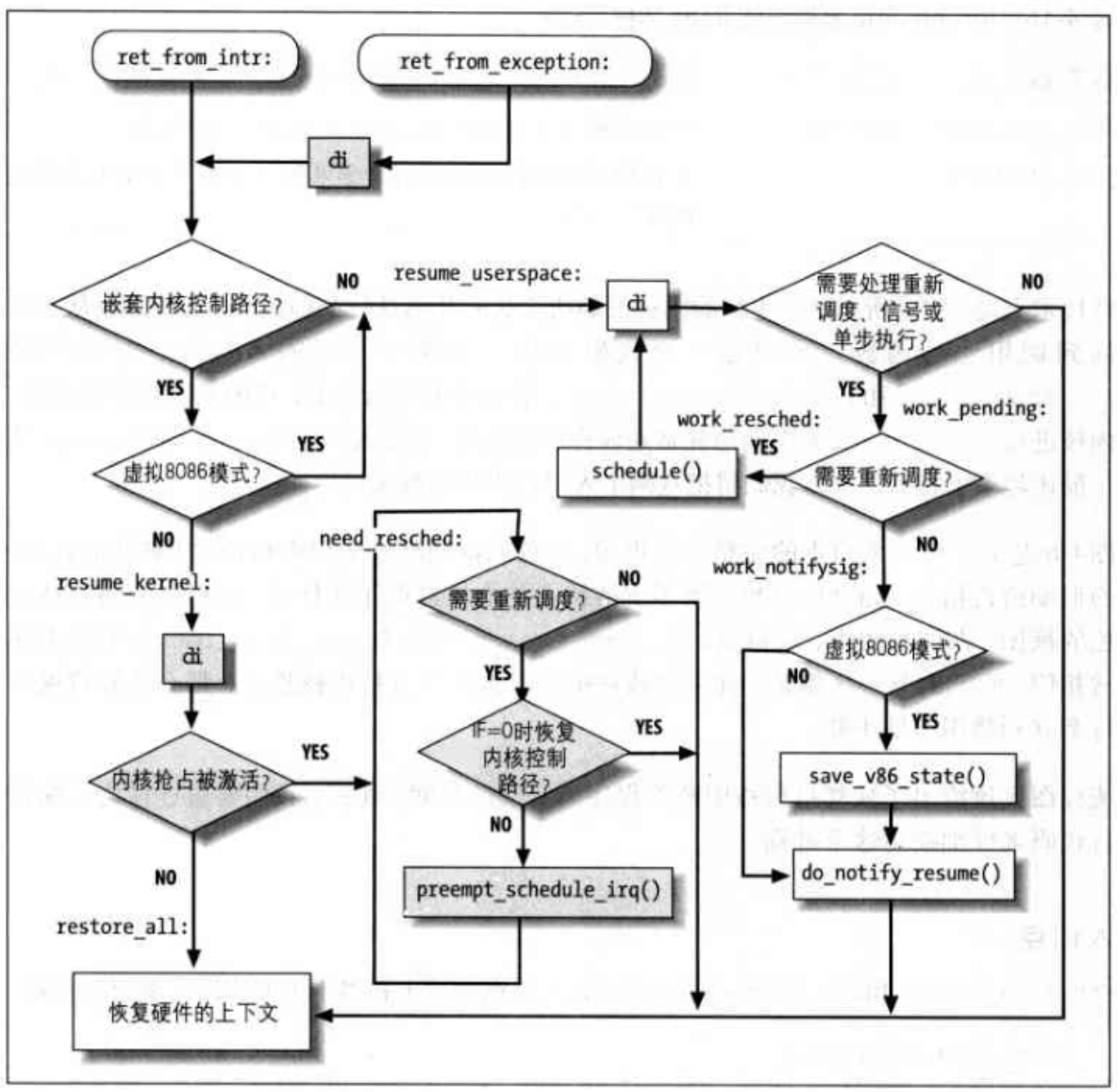

我们用《深入理解Linux内核》的一张大图来收尾。

我们的ret_from_intr和ret_from_exception本质上等价于:

入口点

ret_from_exception:

cli // 只有从异常返回时才使用 cli,禁用本地中断

ret_from_intr:

movl $-8192, %ebp // 将当前 thread_info 描述符的地址装载到 ebp 寄存器

andl %esp, %ebp

movl 0x30(%esp), %eax

movb 0x2c(%esp), %al

// 根据发生中断或异常压入栈中的 cs 和 eflags 寄存器的值,

// 确定中断的程序在中断时是否运行在用户态

testl $0x0002003, %eax

jnz resume_userspace

jpm resume_kernel恢复内核控制路径

rusume_kernel:

cli

cmpl $0, 0x14(%ebp) // 如果 thread_info 描述符的 preempt_count 字段为0(运行内核抢占)

jz need_resched // 跳到 need_resched

restore_all: // 否则,被中断的程序重新开始执行

popl %ebx

popl %ecx

popl %edx

popl %esi

popl %edi

popl %ebp

popl %eax

popl %ds

popl %es

addl $4, %esp

iret // 结束控制检查内核抢占

need_resched:

movl 0x8(%ebp), %ecx

testb $(1<<TIF_NEED_RESCHED), %cl // 如果 current->thread_info 的 flags 字段中的 TIF_NEED_RESCHED == 0,没有需要切换的进程

jz restore_all // 因此跳到 restore_all

testl $0x00000200, 0x30(%ebp) // 如果正在被恢复的内核控制路径是在禁用本地 CPU 的情况下运行

jz restore_all // 也跳到 restore_all,否则进程切换可能回破坏内核数据结构

call preempt_schedule_irq // 进程切换,设置 preempt_count 字段的 PREEMPT_ACTIVE 标志,大内核锁计数器暂时设置为 -1,调用 schedule()

jmp need_resched 恢复用户态程序

resume_userspace:

cli // 禁用本地中断

movl 0x8(%ebp), %ecx

// 检测 current->thread_info 的 flags 字段,

// 如果只设置了 TIF_SYSCALL_TRACE,TIF_SYSCALL_AUDIT 或 TIF_SINGLESTEP 标志,

// 跳到 restore_all

andl $0x0000ff6e, %ecx

je restore_all

jmp work_pending检测重调度标志

work_pending:

testb $(1<<TIF_NEED_RESCHED), %cl

jz work_notifysig

work_resched:

call schedule // 如果进程切换请求被挂起,选择另外 一个进程运行

cli

jmp resume_userspace // 当前面的进程要恢复时处理挂起信号、虚拟 8086 模式和单步执行

work_notifysig:

movl %esp, %eax

testl $0x00020000, 0x30(%esp)

je 1f

// 如果用户态程序 eflags 寄存器的 VM 控制标志被设置

work_notifysig_v86:

pushl %ecx

call save_v86_state // 在用户态地址空间建立虚拟8086模式的数据结构

popl %ecx

movl %eax, %esp

1:

xorl %edx, %edx

call do_notify_resume // 处理挂起信号和单步执行

jmp restore_all // 恢复被中断的程序Reference

Linux内核19-中断描述符表IDT的初始化-腾讯云开发者社区-腾讯云 (tencent.com)

Linux内核硬中断 / 软中断的原理和实现-腾讯云开发者社区-腾讯云 (tencent.com)

linux内核之tasklet使用_tasklet 改绑定-CSDN博客

深入理解 Linux 内核—-中断和异常_ret_from_exception-CSDN博客中断与异常

中断通常被定义为一个事件:让事件改变处理器执行的指令顺序这样的事件,与CPU芯片内外部硬件电路产生的电信号相对应!

中断通常分为同步中断与异步中断:

同步中断指的是当指令执行时,由CPU控制单元产生的。之所以称为同步,是因为只有在一条指令终止执行后,CPU才会发出中断!

异步中断是由其他硬件设备依照CPU时钟信号随机产生的

在英特尔微处理器手册中:也会把同步和异步中断分别称为异常和中断

中断则是由间隔定时器或者io设备产生的,举个例子你敲击键盘的时候,你的一次按键就会引发一个中断,希望操作系统介入进行处理!

另一方面异常是由程序的错误产生的,或者是由内核必须处理的异常条件产生的!比如说内核通过发送一个信号来处理异常,或者内核执行恢复异常所需要的步骤,比如说缺页,比如说对内核服务的一个请求

中断信号的作用

顾名思义,中断信号提供了一种特殊的方式来让处理器转而去运行正常控制流之外的代码。当一个中断信号到达的时候CPU必须停止它当前所做的事情,转而切换去处理这些终端。为了做到这一点就需要把内核态堆栈保存PC当前的值,并且把中断相关类型的的一个地址放进程序计数器中。这样才会跳转去执行处理中断的代码。

中断处理器内核执行的最敏感的任务之一,因为它必须要满足:

- 让内核正打算去完成别的事情的,由于中断随时都会到来,因此内核的目标就是:让中断尽可能的处理完尽可能把更多的更详细的处理向后推,所以中断响应分为两个部分:

- 关键而紧急的部分这一部分,内核立即执行。

- 其推迟的部分,则是内核随后执行。

- 因为中断随时会到来,所以内核可能正在处理其中一个中断的时候,另一个中断又发生了。应该尽可能地允许这种情况发生,因为这将会保持更多的io设备处于忙状态。因此中断处理程序必须编写成可以使相应的内核控制路径以嵌套的方式进行,执行到最后一个内核控制路径终止时,内核可以恢复被中断进程的执行,或者如果中断信号已导致了重新调度,内核可以切换到另外的进程。

- 尽管内核在处理前一个中断的时候,可以接受新的中断,但在内核代码区中仍然存在着一些临界区,在这些临界区中中断必须被禁止

中断和异常

英特尔文档把中断和异常又分为了以下几类:

- 中断:

又分出两类即:

类型 说明 可屏蔽中断 IO设备发出的所有中断请求(Interruppt Request)都产生可屏蔽的中断,它处于两状态:屏蔽的和非屏蔽的,如果一个中断是被屏蔽的,那么控制单元会被它会忽略它 非可屏蔽中断 只有少数的几个危机事件是这样的,非屏蔽的中断总是由CPU辨认 异常:

异常分两类,处理器探测异常和编程异常。

处理器探测异常有三种

类型 说明 故障 通常可以被纠正,一旦纠正,程序就可以在不失连贯性的情况下,重新开始!保存在EIP中的值就是引起故障的指令地址,因此当异常处理程序终止时,那条指令会被重新执行 陷阱 在陷阱执行后,立即报告内核把控制权返回给程序后,就可以继续它的执行而不失去连贯性。保存在EIP中的值是一个随后要执行的指令地址,只有当没有必要重新执行已中止的指令时,才会触发陷阱。陷阱的主要目的是为了调试程序 异常终止 异常终止指的是发生了一个严重的错误及控制单元出现了问题,不能在EIP寄存器中保存引发了这个异常指令所在的确切位置。异常终止用的报告严重的错误,如硬件故障或系统表中无效的值或不一样的值。 编程异常:在编程者发出请求时发生是由int或int3指令触发的当into(检查溢出)和bound(检查地址出界)指令检查的条件不为真时,会引发编程异常控制单元!编程异常当作陷阱来处理,编程异常也被称为软中断,这样的异常常有两种的用途执行:系统调用以及给调试程序通报一个特定的事件。

IRQ与中断

每个能够发出中断请求的硬件设备系都有一条名为IRQ的输出线,所有现有的IRQ线都与一个名为可编程中断控制器的硬件电路的输入引脚相连,可编程中断控制器执行下列动作:

- 监视IRQ线检查产生的信号,如果有两条或两条以上的IRQ线上产生信号,选择引脚编号较小的IRQ线

- 如果一个引发信号出现在线上,那么它会把接收到的信发信号转换成对应的向量,把这个向量存放在中断控制器的一个io端口,从而允许CPU通过数据总线读取此向量。把引发信号发送到处理器的INTR引脚,也就是产生了一个中断

- 等待直到CPU通过把这个中断信号写进可编程中断控制器的io端口号,来确认它,当这种情况发生时,清理INTR线。然后继续监视。

异常

这里给出一些常见的异常:

异 常 一 览 表 向量号 异常名称 异常类型 出错代码 相关指令 0 除法出错 故障 无 DIV,IDIV 1 调试异常 故障/陷阱 无 任何指令 3 单字节INT3 陷阱 无 INT 3 4 溢出 陷阱 无 INTO 5 边界检查 故障 无 BOUNT 6 非法操作码 故障 无 非法指令编码或操作数 7 设备不可用 故障 无 浮点指令或WAIT 8 双重故障 中止 有 任何指令 9 协处理器段越界 中止 无 访问存储器的浮点指令 0AH 无效TSS异常 故障 有 JMP、CALL、IRET或中断 0BH 段不存在 故障 有 装载段寄存器的指令 0CH 堆栈段异常 故障 有 装载SS寄存器的任何指令、对SS寻址的段访问的任何指令 0DH 通用保护异常 故障 有 任何特权指令、任何访问存储器的指令 0EH 页异常 故障 有 任何访问存储器的指令 10H 协处理器出错 故障 无 浮点指令或WAIT 11H—0FFH 软中断 陷阱 无 INT n 中断向量表

中断描述符表IDT是一个系统表,它与每一个中断或者异常向量相联系

每一个向量在表中都有相应的中断或异常处理程序的入口地址,内核在允许中断发生前,必须适当初始化IDT

下图为IDT的结构表示图:

这些描述符是:

- 任务门

Task Gate:当中断信号发生时,必须取代当前进程的那个进程的TSS选择符,存放在任务门中- 中断门

Interrupt Gate:包含段选择符和中断或异常处理程序的段内偏移量,当控制权转移到应适当的段时,处理器清IF标志,从而关闭即将会发生的可屏蔽中断。- 陷阱门

Trap Gate:与中断门相似只是控制权传递到一个适当的段时处理器不修改IF标志Linux使用中断门处理中断应用陷阱门处理异常硬件处理

现在描述CPU控制单元是如何处理中断和异常的!

我们现在假定内核已经被初始化,因此CPU将会在保护模式下运行。

当执行了一条指令后,CS和EIP这对寄存器将会包含下一条将要执行的指令的逻辑地址。在处理那条指令之前控制单元会检查在运行前一条指令是否已经发生一个中断或者异常,如果发生了,那么它将会:

确定与中断或异常关联的向量(看一眼是哪个异常)

读由寄存器指向的

IDT表中的i项(肘!IDT表爆破)从

gdpr寄存器中获取GDP的基地址,并在GDP中查找,以读取IDT表项的选择符所标识的段描述符。这个描述符指定中断或异常处理程序所在段的基地址(看看这个程序在哪里)确信中断事由授权的中断发生源发出的,首先将当前特权级CPL与段描述符的描述符特权级DPL的相比较:如果CPL小于DPL了就会产生一个

general protection异常,因为中断处理程序的特权不能低于引起中断的程序的特权!对于编程异常则需要做进一步的安全检查:比较CPL了与处于IDT中的门描述符的DPL了,如果DPL小于CPL了那么就产生一个general protection,这最后一个检查可以避免用户应用程序访问特殊的陷阱门和中断门(配不配处理这个异常)检查是否发生了特权级变化:也就是说CPL是否不同于所选择的段描述符的DPL,如果是,控制单元必须开始使用与新的特权级相关的栈,通过执行以下步骤来做到这一点:

- 读TR寄存器以访问运行进程的TSS段

- 用于新特权级相关的栈段和栈指针的正确值装载SS和ESP寄存器这些值,可以在TSS中找到在新的段中

- 保存SS和ESP以前的值,这些值定义了与旧特训级相关的栈的逻辑地址。

如果故障已经发生,用引起异常的指令地址装载CS和EIP寄存器,从而使得这条指令能够再次被执行!

在栈中保存eflags,cs,EIP等内容,如果引用异常产生了一个硬件出错码,把它保存到栈中,装在CS和EIP寄存器其值分别为IDT表中第I项门描述服务的段选择符和偏移量字段,这些值给出了中断或者异常处理的第一条指令的逻辑地址!

控制单元所执行的最后一步就是跳转到这些异常处理程序,换句话说处理完中断信号后控制单元所执行的指令,就是被选中处理程序的第一条指令!

当中断或处理结束后和异常被处理结束后相应的处理程序必须参与生一条iret指令,他把控制权转交给被中断的进程。这将会迫使控制单元:

- 用保存在栈中的值装在CS或eflags寄存器,如果一个硬件出错码曾经被压入栈中,并且在EIP内容的上面,那么执行Iret指令前必须弹出这个硬件错误码(准备回家)

- 检查处理程序的CPL是否等于CS中的最低两位的值如果是iret终止执行,否则执行下一步。(看看特权级够不够)

- 从栈中装载SS和ESP寄存器因此返回到与特权级相关的栈(也就是恢复栈)

- 检查DS ES FS 以及 GS段寄存器的内容,如果其中一个寄存器包含选择符是一个段描述符,并且其的DPL值小于CPL了,那么我们会清理相应的段寄存器控制单元,这么做是为了防止用户态的程序利用内核以前所用的段寄存器,如果不清理这些寄存器,那么一些怀有恶意的用户态程序就有可能利用他们来访问内核地址。(安全处理,安全恢复环境)

中断和异常处理程序的嵌套执行

每个中断或异常都会引起一个内核控制路径,或者说当前的进程在内核态执行单独的指令序列。

内核控制路径可以任意嵌套!一个中断处理程序可以被另一个中断处理程序所中断,因此这样就引起了内核控制路径的嵌套执行。允许内核控制路径嵌套执行必须要付出相应的代价,也就是中断处理程序必须永不阻塞换,中断处理程序在运行期间是不能够发生进程切换。

基于以下两个主要原因,Linux交错执行内核控制路径:

- 为了提高可编程中断控制器和设备控制中器的吞吐量。假定设备控制器在一条线上产生了一条信号,pic把这个信号转换成一个外部中断,然后pic和控制设备器保持阻塞一直到pic从内核CPU处接收一条应答信息!由于内核控制路径的交错执行内核即使正在处理前一个中断也能够发送应答。

- 为了实现一种没有优先级的中断模型,每个C中断处理程序都可以被另一个中断处理程序所延缓,因此在硬件设备之间没必要预定义优先级,这简化了内核代码,也提高了内核的可移植性!

初始化IDT

Linux在基于Intel给出的三种门之外,还更加细分了他们:

中断门(interrupt gate):用户态的进程不能访问的一个lntel中断门(门的DPL字段为0)。所有的Linux中 断处理程序都通过中断门激活,并全部限制在内核态。

系统门(syslem gate):用户态的进程可以访问的一个Intel陷阱门(门的DPL字段为到.通过系统门来激 活三个Linux异常处理程序,它们的向量是4,5及128,因此,在用户态下.可以 发布into、 bound及int $Ox80三条汇编语言指令。

系统中断门(system interrupt gate):能够被用户态进程访问的Intel中断门(门的DPL字段为3). 与向量3相关的异常 处理程序是由系统中断门激活的,因此,在用户态可以使用汇编语言指令int3.

陷阱门(Irapgate):用户态的进程不能访问的一个Inte)陷阱门(f]的DPL字段为0). 大部分Linux异 常处理程序都通过陷阱门来激活.

任务门(task gate):不能被用户态进程访问的Intel任务门(门的DPL字段为0).Linux对”Doublefault” 异常的处理程序是由任务门激活的.

IDT会被初始化两次。第一次是在BIOS程序中,此时CPU还工作在实模式下。一旦Linux启动,IDT会被搬运到RAM的受保护区域并被第二次初始化,因为Linux不会使用任何BIOS程序。

IDT结构被存储在idt_table表中,包含256项。idt_descr变量存储IDT的大小和它的地址,在系统的初始化阶段,内核用来设置idtr寄存器,专用汇编指令是lidt。

内核初始化的时候,汇编函数setup_idt()用相同的中断门填充idt_table表的所有项,都指向ignore_int()中断处理函数:

>setup_idt: lea ignore_int, %edx movl $(__KERNEL_CS << 16), %eax movw %dx, %ax /* = 0x0010 = cs */ movw $0x8e00, %dx /* 中断门,DPL=0 */ lea idt_table, %edi /* 加载idt表的地址到寄存器edi中 */ mov $256, %ecx >rp_sidt: movl %eax, (%edi) /* 设置中断处理函数 */ movl %edx, 4(%edi) /* 设置段描述符 */ addl $8, %edi /* 跳转到IDT表的下一项 */ dec %ecx /* 自减 */ jne rp_sidt ret中断处理函数

ignore_int(),也是一个汇编语言编写的函数,相当于一个null函数,它执行:

- 保存一些寄存器到堆栈中。

- 调用printk()函数打印

Unknown interrupt系统消息`。- 从堆栈中恢复寄存器的内容。

- 执行iret指令回到调用处。

正常情况下,此时的中断处理函数ignore_int()是不应该被执行的。如果在console或者log日志中出现

Unknown interrupt的消息,说明发生硬件错误或者内核错误。 完成这次IDT表的初始化之后,内核还会进行第二次初始化,用真正的trap或中断处理函数代替刚才的null函数。一旦这两步初始化都完成,IDT表就包含具体的中断、陷阱和系统门,用以控制每个中断请求。

中断处理

这里讨论三种中断类型:

IO中断,时钟中断。和处理器间中断io

中断处理程序必须足够灵活地给多个设备同时提供服务,比如说在PCI总线的体系架构中几个设备可以共享一个IRQ线,这也就意味着仅仅中断向量是并不能说明所有问题的!中断处理程序的灵活性是以两种不同的方式实现的:

IRQ共享

中断处理程序执行多个中断服务例程,每个中断服务例程是一个与单独设备相关的函数,因此不可能预先知道哪个特定的设备产生,因此每个IRQ,也就是中断服务例程,都会被执行验证它的设备是否需要关注,如果是,当设备产生中断时则需要执行相关的所有操作

IRQ动态分配

一条线可能在最后的时刻才会与一个设备驱动程序相关联,这样,即使几个硬件设备并不共享线,同一个向量也可以在这几个设备在不同时刻中使用。当一个中断发生时,并不是所有的操作都具有急迫性,,因此Linux会把紧随中断要执行的操作分为三类:

紧急的:这样的操作比如说对pic应答中断,对pic或设备控制器中编程重修改,由设备和处理器同时访问的数据结构这样的操作都可以很快的被执行,他们是紧急的,因为他们必须要尽快的执行紧急操作!要在一个中断处理程序内立即执行,而且是在禁止可屏蔽中断的情况下

非紧急的:这样的操作比如说修改那些只有处理器才会访问的数据结构,这样的操作必须也很快完成,因此它们由中断处理程序立即执行,但它们是在开中断的情况下执行的

非紧急可延迟的:比如说把缓冲区的内容拷贝到进程的地址空间中,这样的操作可能被延迟较长的时间间隔,而不会影响内核的操作!

不管引起中断的电路类型如何所有的io中断处理程序都执行四个基本的操作:

- 在内核态堆栈中保存的值与寄存器的内容

- 为正在给线服务的pic发送个应答,这将允许pic进一步发出中断

- 执行共享这个IRQ的所有设备都中断服务例程

- 跳到ret_from_intr的地址后终止

为一个IRQ可配置设备选择一条线,有三种方式:

- 设置一些硬件跳线跳接器

- 安装设备时执行一个实用程序,这样的程序可以让用户选择一个可用的RQ号或者探测系统自身以确定一个可用的IRQ号

- 在系统启动时执行一个硬件协议,外设宣布他们准备使用哪些中断线,然后协商一个最终的值以尽可能减少冲突,该过程一旦完成,每个中断处理程序都会通过访问设备的某个IO端口函数来读取所分配的IRQ

数据结构

对于每一个外设的IRQ都用 struct irq_desc 来描述,我们称之中断描述符(struct irq_desc)。linux kernel中会有一个数据结构保存了关于所有IRQ的中断描述符信息,我们称之中断描述符DB(上图中红色框图内)。当发生中断后,首先获取触发中断的HW interupt ID,然后通过irq domain翻译成IRQ number,然后通过IRQ number就可以获取对应的中断描述符

中断描述符